Diferència entre revisions de la pàgina «Storage pool»

| (Hi ha 3 revisions intermèdies del mateix usuari que no es mostren) | |||

| Línia 4: | Línia 4: | ||

| + | <h2> Ceph RBD</h2> | ||

| − | + | Realizamos un "apt update", para actualizar los paquetes antes de instalar el "Ceph". | |

| − | [[File: | + | [[File:Capturaa9.PNG|Add|border|605px]] |

| − | + | Accedemos al nodo principal vamos al apartado de Ceph , y le damos a "Instalar Ceph" | |

| − | + | Nos saldrá una pestaña, le damos a "Start pacific installation". | |

| − | [[File: | + | [[File:Capturaa10.PNG|Add|border|605px]] |

| − | + | Comenzara la instalación del Ceph en el nodo. | |

| − | [[File: | + | [[File:Capturaa11.PNG|Add|border|585px]] |

| + | |||

| + | Nos saldrá "Installed ceph pacific successfully!", le damos a "next". | ||

| + | |||

| + | [[File:Capturaa12.PNG|Add|border|580px]] | ||

| + | |||

| + | En "Public Network" ponemos la ip del nodo que estamos creando el Ceph, y en "Monitor node", ponemos el mismo nodo desde el que estamos instalando. | ||

| + | |||

| + | [[File:Capturaa13.PNG|Add|border|590px]] | ||

| + | |||

| + | Nos saldrá "Installation Successful",le damos a <b>"Finish"</b>, y acabara la instalación. | ||

| + | |||

| + | [[File:Capturaa14.PNG|Add|border|590px]] | ||

| + | |||

| + | Realizamos los mismo en el otro nodo, lo que no nos pedirá configurar-lo ya que ya lo hemos echo en este. | ||

| + | |||

| + | [[File:Capturaa19.PNG|Add|border|590px]] | ||

| + | |||

| + | <h2>Creación de la Pool y del RBD</h2> | ||

| + | |||

| + | Accedemos al "Ceph" del primer nodo y vamos a "OSD". | ||

| + | |||

| + | [[File:Capturaa15.PNG|Add|border|170px]] | ||

| + | |||

| + | Seleccionamos la opción "Create: OSD". | ||

| + | |||

| + | [[File:Capturaa16.PNG|Add|border|510px]] | ||

| + | |||

| + | En "Disk", elegimos el disco que se va a utilizar para el HA y el Ceph, que va a ser el sdb y le damos a "Create". | ||

| + | |||

| + | [[File:Capturaa17.PNG|Add|border|585px]] | ||

| + | |||

| + | Esperamos a que se cree. | ||

| + | |||

| + | [[File:Capturaa18.PNG|Add|border|315px]] | ||

| + | |||

| + | Hacemos lo mismo en el otro nodo, y nos saldrá el osd.0 del nodo5 y el osd.1 del nodo 6. | ||

| + | |||

| + | [[File:Capturaa20.PNG|Add|border|600px]] | ||

| + | |||

| + | Configuramos el ceph para que nos salga que todo esta "Ok" y en verde con solo dos nodos ya que el ceph minimo por defecto serian 3 nodos y no 2. | ||

| + | |||

| + | Hacemos un nano | ||

| + | |||

| + | <pre>nano /etc/pve/ceph.conf</pre> | ||

| + | |||

| + | Y editamos el campos "osd_pool_default_min_size" a 1 y "osd_pool_default_size" a 2. | ||

| + | |||

| + | [[File:Capturaa21.PNG|Add|border|800px]] | ||

| + | |||

| + | Ahora tenemos que crear la Pool, vamos a "Ceph" y a "Pool", configuramos la pool como en la imagen. | ||

| + | |||

| + | [[File:Capturaa36.PNG|Add|border|595px]] | ||

| + | |||

| + | Clicamos en la pool creada y le damos a editar, y ponemos size 2 y min.size 1. | ||

| + | |||

| + | [[File:Capturaa37.PNG|Add|border|595px]] | ||

| + | |||

| + | Podemos ver la pool creada. | ||

| + | |||

| + | [[File:Capturaa38.PNG|Add|border|600px]] | ||

| + | |||

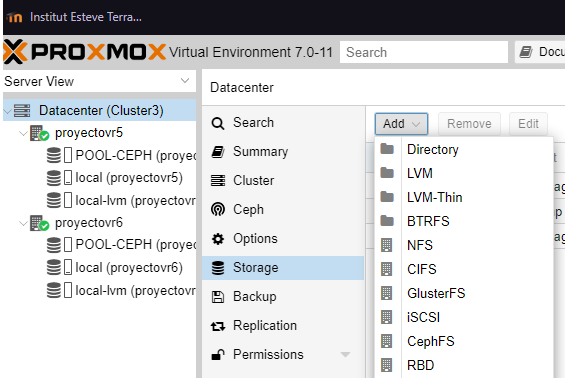

| + | Creamos la pool RBD, en Cluster, vamos a "Storage" le damos a "Add" y clicamos en "RBD". | ||

| + | |||

| + | [[File:Capturaa39.PNG|Add|border|565px]] | ||

| + | |||

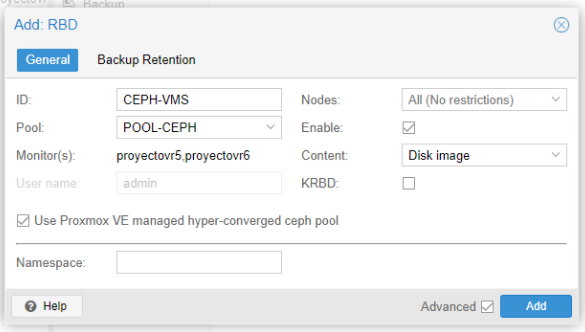

| + | Le ponemos un ID, y seleccionamos la creada en el ceph. | ||

| + | |||

| + | [[File:Capturaa40.PNG|Add|border|585px]] | ||

| + | |||

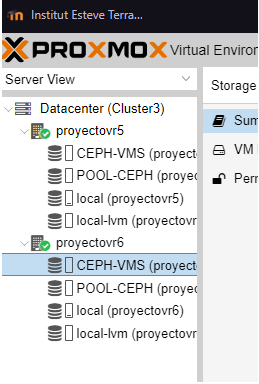

| + | Y ya podemos ver la pool creada, y el RBD CEPH-VMS. | ||

| + | |||

| + | [[File:Capturaa41.PNG|Add|border|259px]] | ||

| + | |||

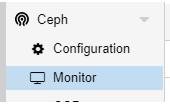

| + | Vamos al apartado de Ceph y vamos a "monitor". | ||

| + | |||

| + | [[File:Capturaa42.PNG|Add|border|170px]] | ||

| + | |||

| + | Le damos a "Add", para añadir al segundo nodo. | ||

| + | |||

| + | [[File:Capturaa43.PNG|Add|border|305px]] | ||

| + | |||

| + | Seleccionamos el nodo proyectovr6 y le damos a "Create". | ||

| + | |||

| + | [[File:Capturaa44.png|Add|border|295px]] | ||

| + | |||

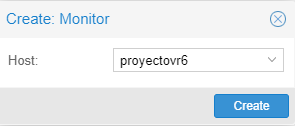

| + | Ya tenemos el segundo nodo como monitor secundario. | ||

| + | |||

| + | [[File:Capturaa45.png|Add|border|595px]] | ||

| + | |||

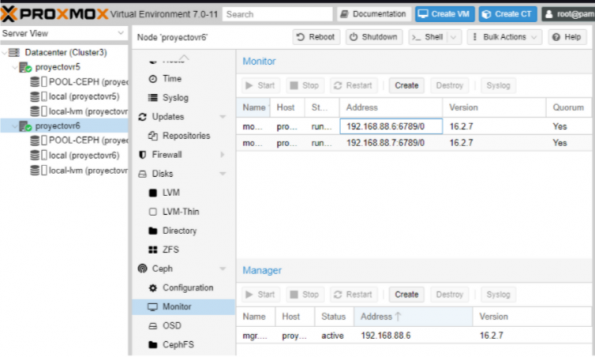

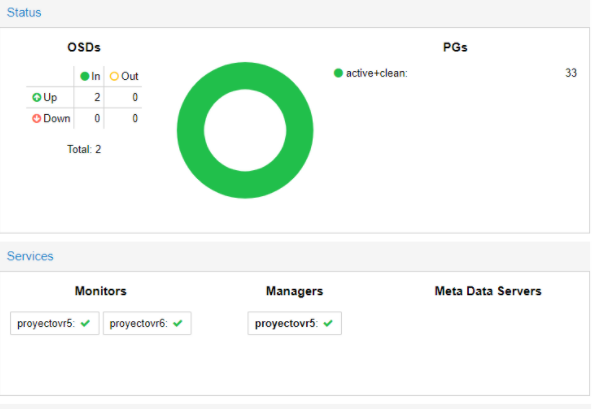

| + | Vamos al ceph y podemos ver el Status en OK. | ||

| + | |||

| + | [[File:Capturaa22.PNG|Add|border|595px]] | ||

| + | |||

| + | [[File:Capturaa23.PNG|Add|border|595px]] | ||

| + | |||

| + | |||

| + | <h2>HA Proxmox</h2> | ||

| + | |||

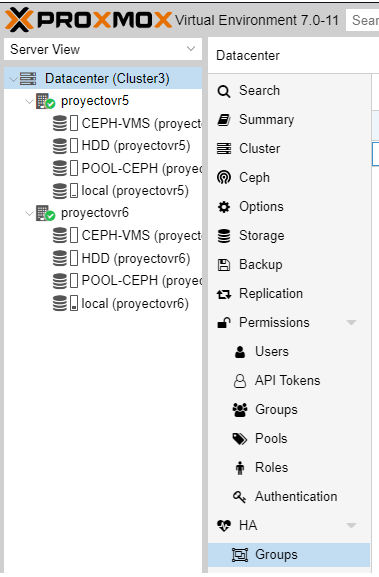

| + | Vamos al cluster y le damos a "HA", vamos a Groups. | ||

| + | |||

| + | [[File:Capturaa46.png|Add|border|380px]] | ||

| + | |||

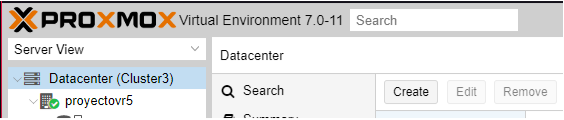

| + | Le damos a "Create". | ||

| + | |||

| + | [[File:Capturaa47.png|Add|border|565px]] | ||

| + | |||

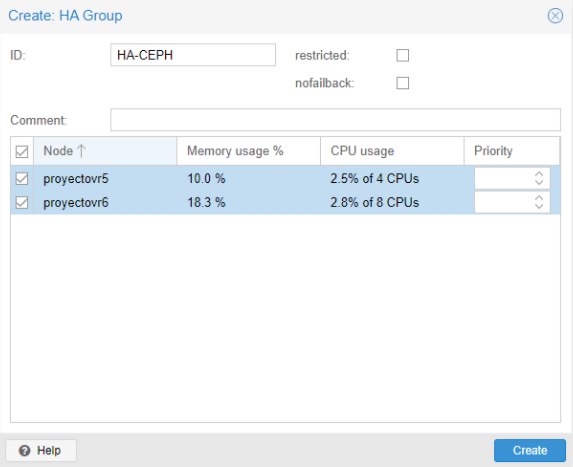

| + | Le ponemos un nombre en "ID" seleccionamos los 2 nodos y le damos a "Create". | ||

| + | |||

| + | [[File:Capturaa48.png|Add|border|575px]] | ||

| + | |||

| + | Podemos ver que se ha creado. | ||

| + | |||

| + | [[File:Capturaa33.PNG|Add|border|800px]] | ||

| + | |||

| + | Vamos a HA. | ||

| + | |||

| + | [[File:Capturaa35.PNG|Add|border|270px]] | ||

| + | |||

| + | Le damos a "Add", seleccionamos el id de la VM y el grupo creado previamente en "Group" "HA-CEPH". | ||

| + | |||

| + | [[File:Capturaa49.png|Add|border|575px]] | ||

| + | |||

| + | Comprobamos que se ha creado correcamente.. | ||

| + | |||

| + | [[File:Capturaa34.PNG|Add|border|800px]] | ||

| + | |||

| + | <h2>Raspberry Pi Qdevice</h2> | ||

| + | |||

| + | Ya que mediante el Ceph con 2 nodos no conseguimos el HA ya que mínimo son 3 instalamos una rasberry PI y la añadimos como otro nodo para cumplir que sean 3 y se pasen. | ||

| + | |||

| + | Nos descargamos "Raspberry Pi Imager", para instalar sistemas en la SD de una rasberry, lo ejecutamos y seleccionamos la versión de Ubuntu server y elegimos la SD de 8GB. | ||

| + | |||

| + | [[File:Capturaa75.png|Add|border|600px]] | ||

| + | |||

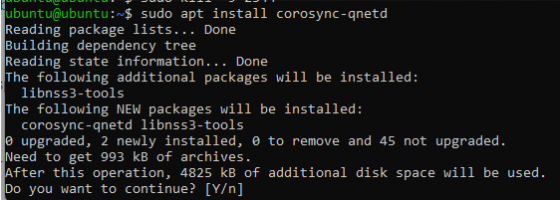

| + | Accedemos a las raspberry por ssh, y instalamos el corosync-qnetd. | ||

| + | |||

| + | [[File:Capturaa76.png|Add|border|560px]] | ||

| + | |||

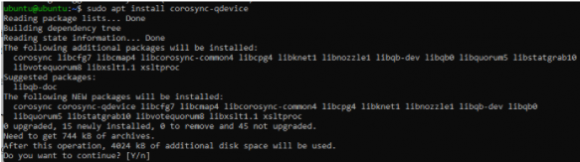

| + | También el corosync-qdevice. | ||

| + | |||

| + | [[File:Capturaa77.png|Add|border|580px]] | ||

| + | |||

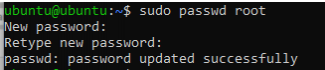

| + | Le damos una contraseña al usuario root mediante passwd. | ||

| + | |||

| + | [[File:Capturaa78.png|Add|border|325px]] | ||

| + | |||

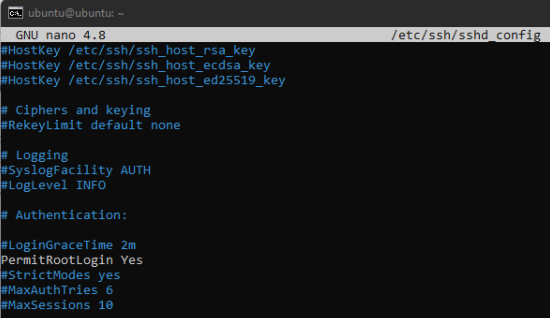

| + | Vamos a la configuración del sshd_config y habilitamos la opción de PermitRootLogin Yes, | ||

| + | |||

| + | [[File:Capturaa79.png|Add|border|550px]] | ||

| + | |||

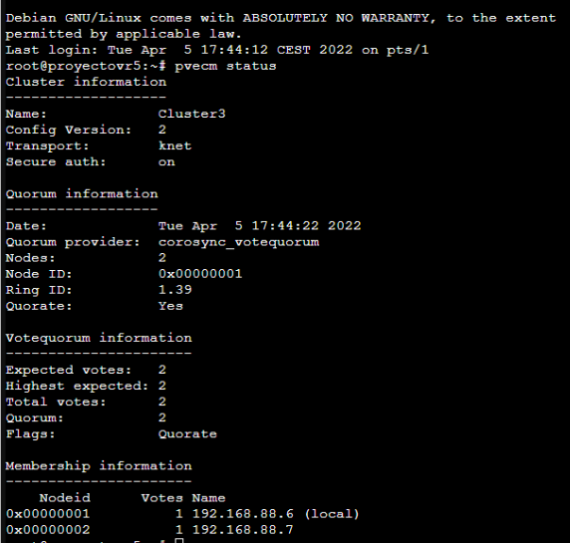

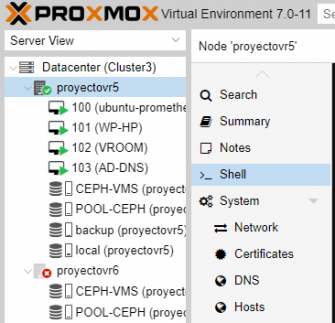

| + | Podemos ver que solo tenemos los 2 nodos. | ||

| + | |||

| + | [[File:Capturaa80.png|Add|border|570px]] | ||

| + | |||

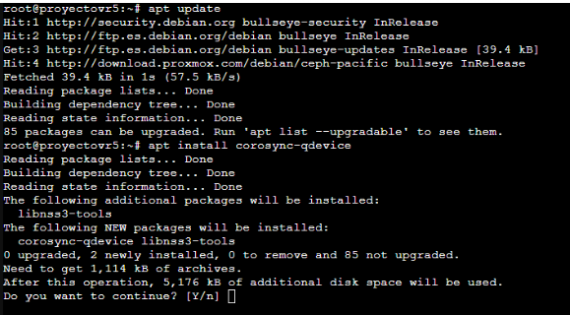

| + | Actualizamos los paquetes en el nodo e instalamos el corosync-qdevice en los dos nodos. | ||

| + | |||

| + | [[File:Capturaa81.png|Add|border|570px]] | ||

| + | |||

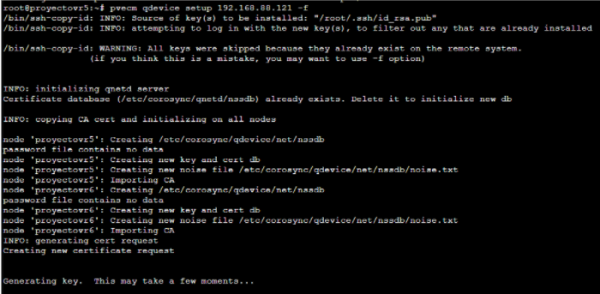

| + | Conectamos la Raspberry con la linea "pvecm qdevice setup 192.168.88.121 -f" | ||

| + | |||

| + | [[File:Capturaa82.png|Add|border|600px]] | ||

| + | |||

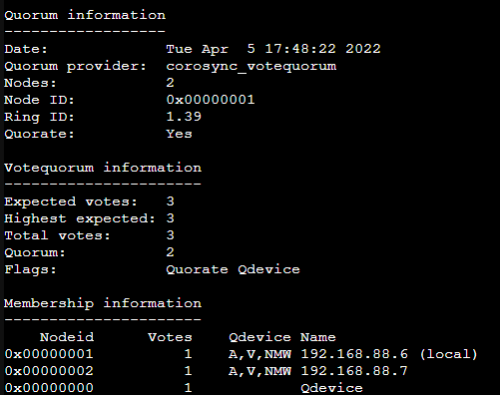

| + | Y podemos ver que ya salen 3 y la rasberry se ha unido correctamente. | ||

| + | |||

| + | [[File:Capturaa83.png|Add|border|500px]] | ||

| + | |||

| + | Apagamos el nodo 2 con la máquina del prometheus, y luego comprobamos que se pasa de nodo. | ||

| + | |||

| + | [[File:Capturaa84.png|Add|border|335px]] | ||

| + | |||

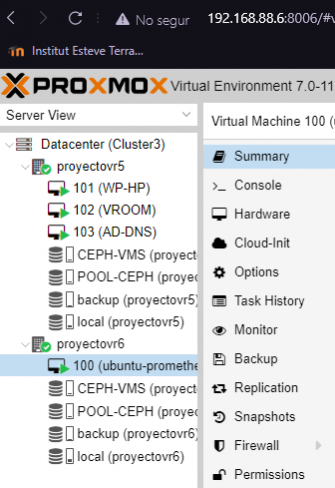

| + | Podemos ver que hemos apagado el nodo proyectovr6 y que la maquina estaba en el nodo apagado. | ||

| + | |||

| + | [[File:Capturaa85.png|Add|border|220px]] | ||

| + | |||

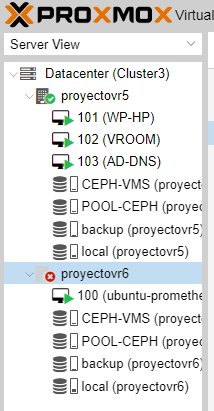

| + | Y ahora vemos que la maquina se migra al otro nodo. | ||

| + | |||

| + | [[File:Capturaa86.png|Add|border|335px]] | ||

Revisió de 14:32, 7 abr 2022

Ceph RBD

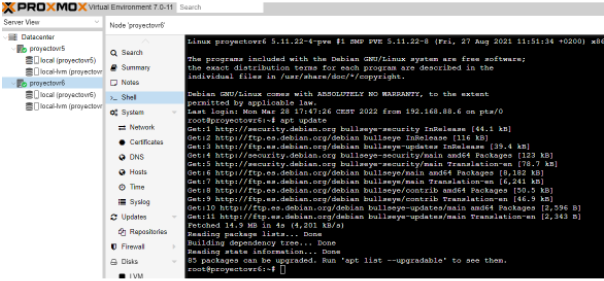

Realizamos un "apt update", para actualizar los paquetes antes de instalar el "Ceph".

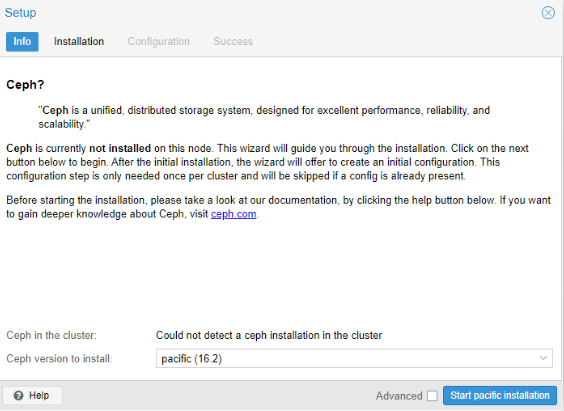

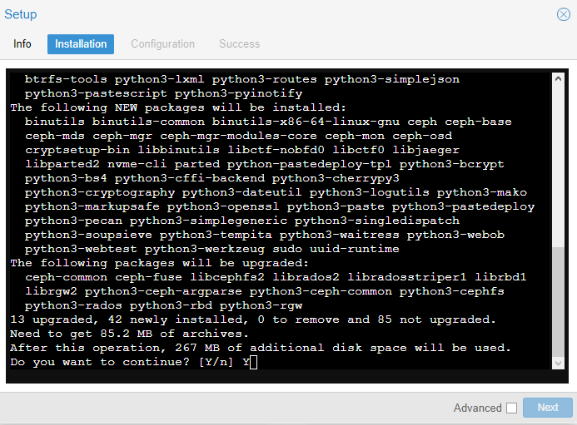

Accedemos al nodo principal vamos al apartado de Ceph , y le damos a "Instalar Ceph"

Nos saldrá una pestaña, le damos a "Start pacific installation".

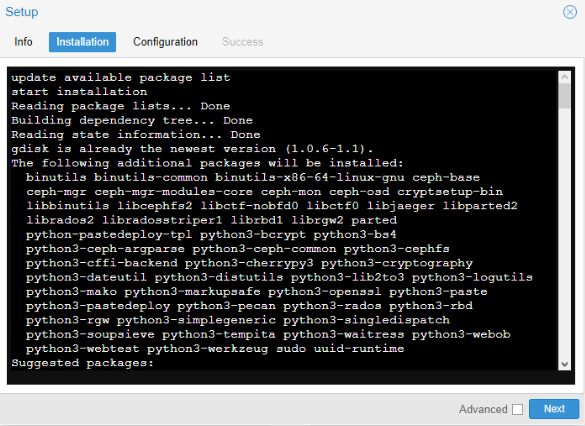

Comenzara la instalación del Ceph en el nodo.

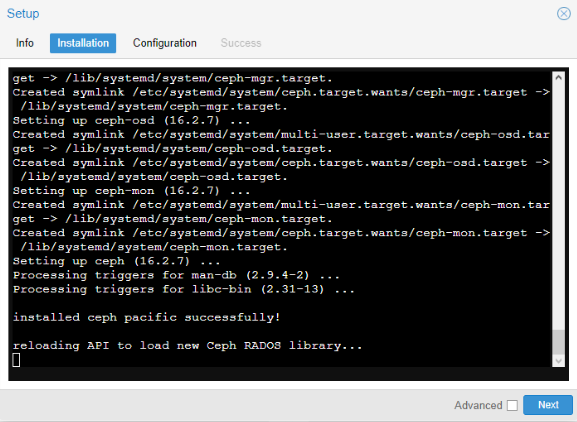

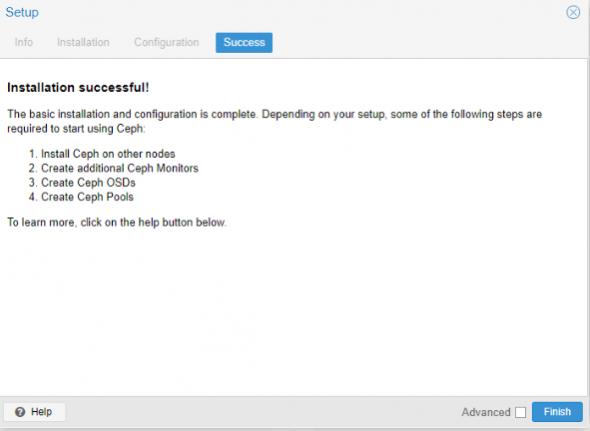

Nos saldrá "Installed ceph pacific successfully!", le damos a "next".

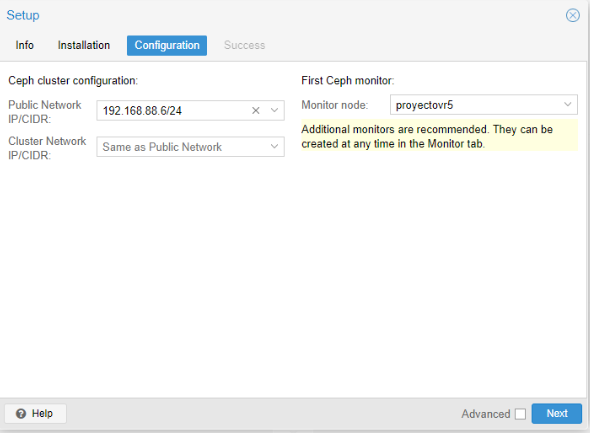

En "Public Network" ponemos la ip del nodo que estamos creando el Ceph, y en "Monitor node", ponemos el mismo nodo desde el que estamos instalando.

Nos saldrá "Installation Successful",le damos a "Finish", y acabara la instalación.

Realizamos los mismo en el otro nodo, lo que no nos pedirá configurar-lo ya que ya lo hemos echo en este.

Creación de la Pool y del RBD

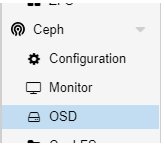

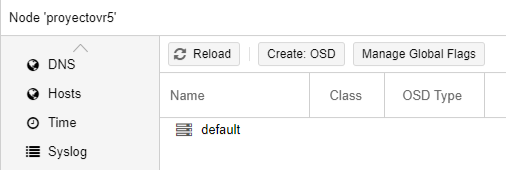

Accedemos al "Ceph" del primer nodo y vamos a "OSD".

Seleccionamos la opción "Create: OSD".

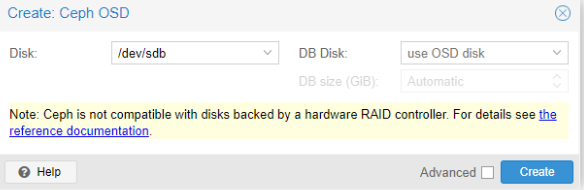

En "Disk", elegimos el disco que se va a utilizar para el HA y el Ceph, que va a ser el sdb y le damos a "Create".

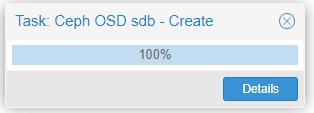

Esperamos a que se cree.

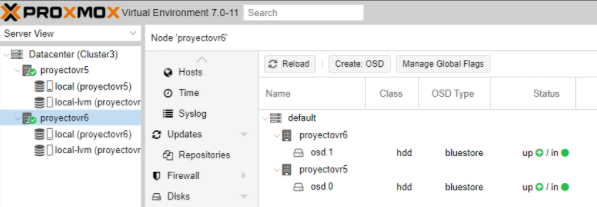

Hacemos lo mismo en el otro nodo, y nos saldrá el osd.0 del nodo5 y el osd.1 del nodo 6.

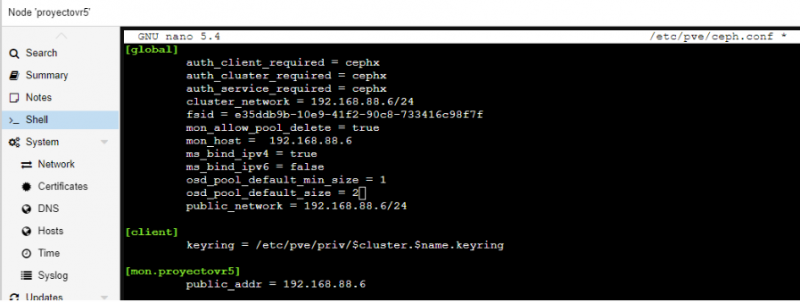

Configuramos el ceph para que nos salga que todo esta "Ok" y en verde con solo dos nodos ya que el ceph minimo por defecto serian 3 nodos y no 2.

Hacemos un nano

nano /etc/pve/ceph.conf

Y editamos el campos "osd_pool_default_min_size" a 1 y "osd_pool_default_size" a 2.

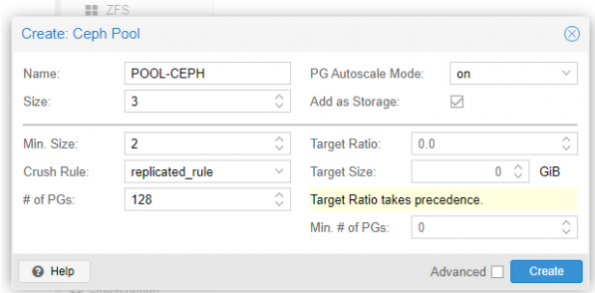

Ahora tenemos que crear la Pool, vamos a "Ceph" y a "Pool", configuramos la pool como en la imagen.

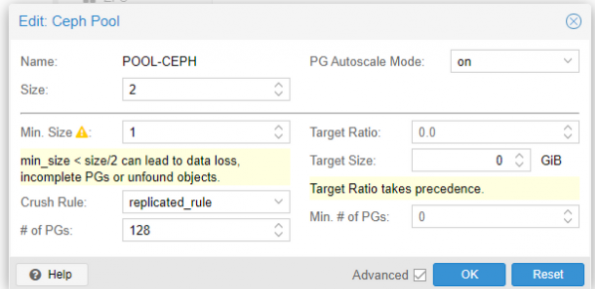

Clicamos en la pool creada y le damos a editar, y ponemos size 2 y min.size 1.

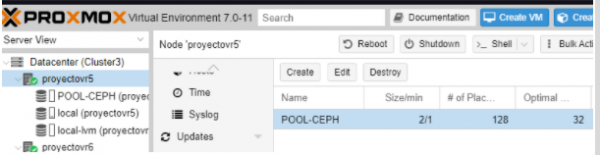

Podemos ver la pool creada.

Creamos la pool RBD, en Cluster, vamos a "Storage" le damos a "Add" y clicamos en "RBD".

Le ponemos un ID, y seleccionamos la creada en el ceph.

Y ya podemos ver la pool creada, y el RBD CEPH-VMS.

Vamos al apartado de Ceph y vamos a "monitor".

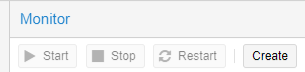

Le damos a "Add", para añadir al segundo nodo.

Seleccionamos el nodo proyectovr6 y le damos a "Create".

Ya tenemos el segundo nodo como monitor secundario.

Vamos al ceph y podemos ver el Status en OK.

HA Proxmox

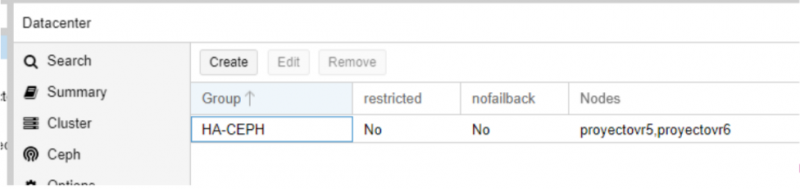

Vamos al cluster y le damos a "HA", vamos a Groups.

Le damos a "Create".

Le ponemos un nombre en "ID" seleccionamos los 2 nodos y le damos a "Create".

Podemos ver que se ha creado.

Vamos a HA.

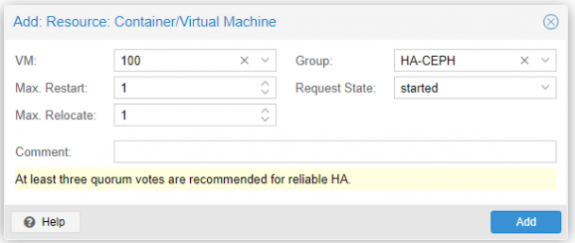

Le damos a "Add", seleccionamos el id de la VM y el grupo creado previamente en "Group" "HA-CEPH".

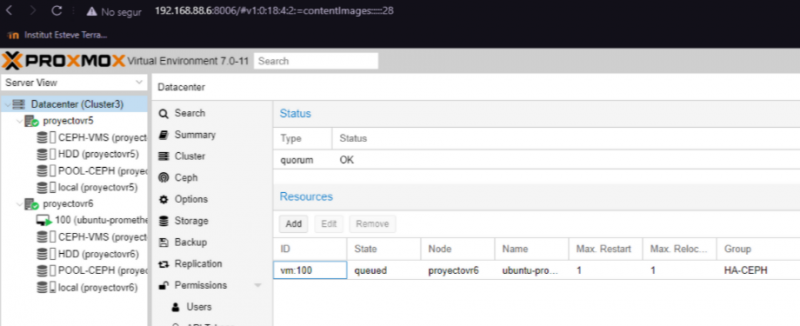

Comprobamos que se ha creado correcamente..

Raspberry Pi Qdevice

Ya que mediante el Ceph con 2 nodos no conseguimos el HA ya que mínimo son 3 instalamos una rasberry PI y la añadimos como otro nodo para cumplir que sean 3 y se pasen.

Nos descargamos "Raspberry Pi Imager", para instalar sistemas en la SD de una rasberry, lo ejecutamos y seleccionamos la versión de Ubuntu server y elegimos la SD de 8GB.

Accedemos a las raspberry por ssh, y instalamos el corosync-qnetd.

También el corosync-qdevice.

Le damos una contraseña al usuario root mediante passwd.

Vamos a la configuración del sshd_config y habilitamos la opción de PermitRootLogin Yes,

Podemos ver que solo tenemos los 2 nodos.

Actualizamos los paquetes en el nodo e instalamos el corosync-qdevice en los dos nodos.

Conectamos la Raspberry con la linea "pvecm qdevice setup 192.168.88.121 -f"

Y podemos ver que ya salen 3 y la rasberry se ha unido correctamente.

Apagamos el nodo 2 con la máquina del prometheus, y luego comprobamos que se pasa de nodo.

Podemos ver que hemos apagado el nodo proyectovr6 y que la maquina estaba en el nodo apagado.

Y ahora vemos que la maquina se migra al otro nodo.