Grup 5 - 6. Storage pool. Configuració de volum compartit d’alta disponibilitat amb Redhat Ceph RBD, GlusterFS, o altres.

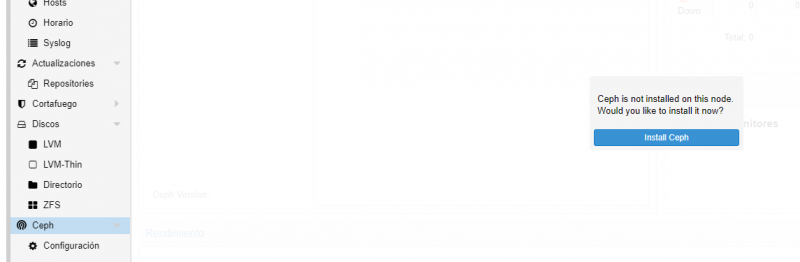

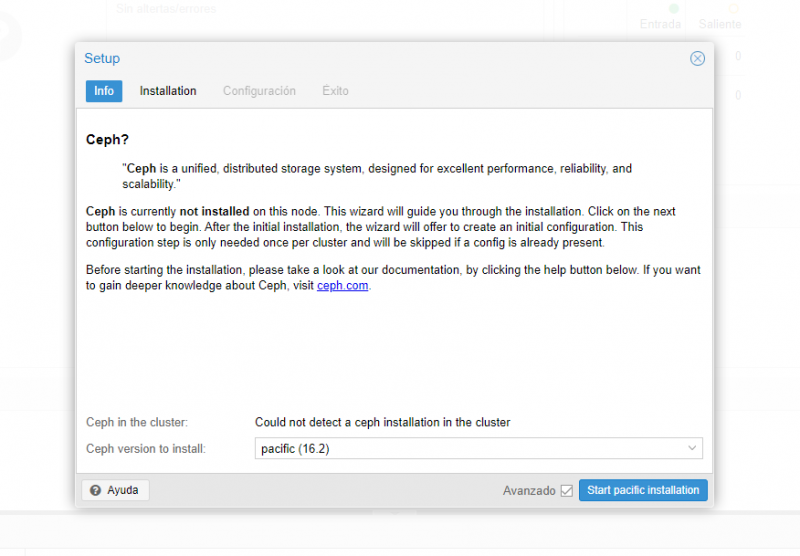

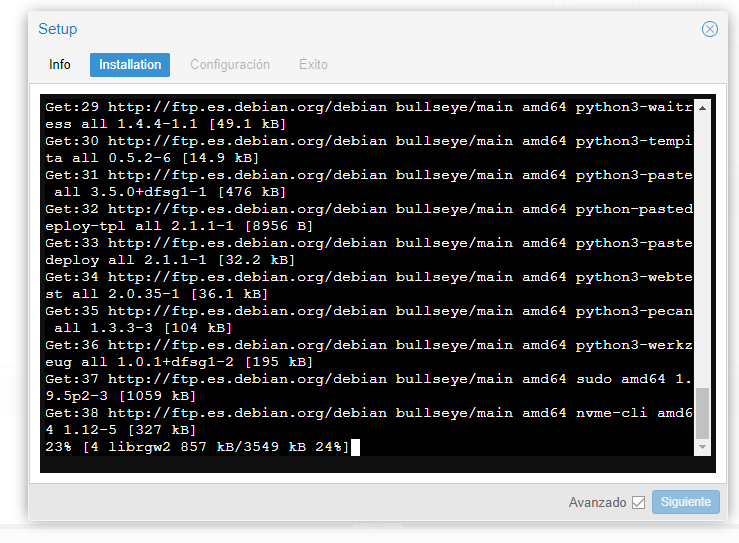

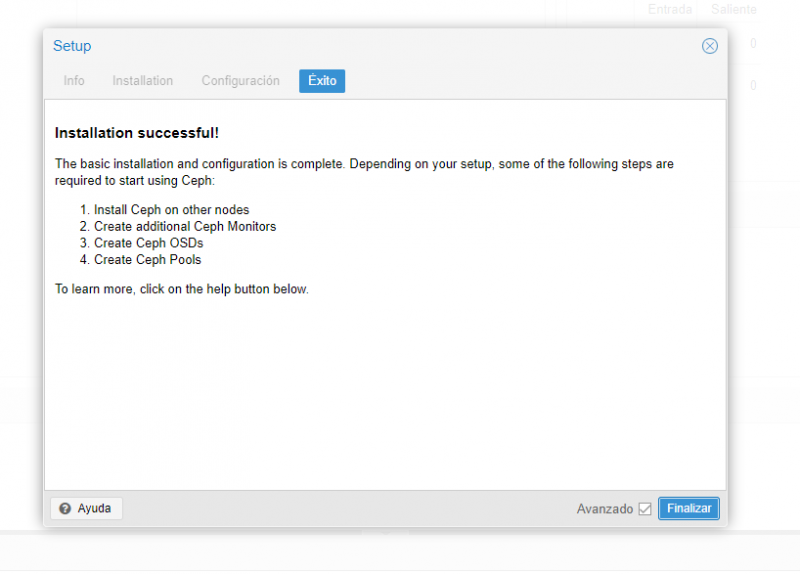

Ahora vamos al apartado del Ceph y empezamos, hacemos click en empezar la instalación y seguimos

Utilizaremos Pacific

Le damos a Y y enter

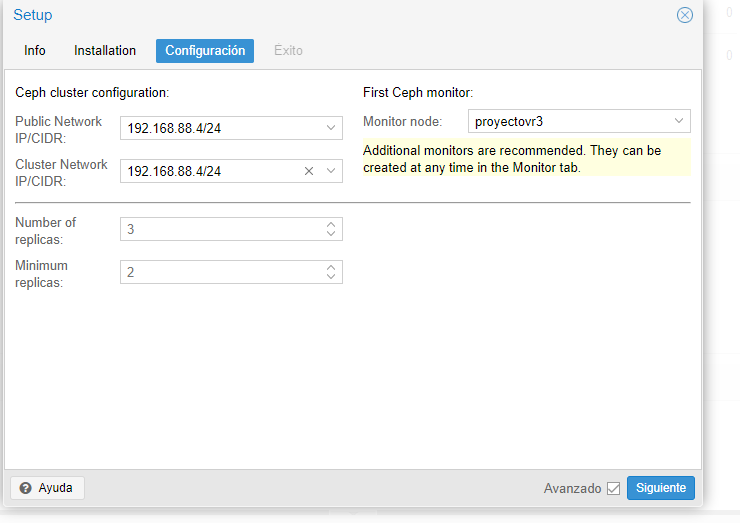

Rellenamos con la IP del servidor y click en siguiente

Finalmente repetimos el mismo proceso para el otro nodo

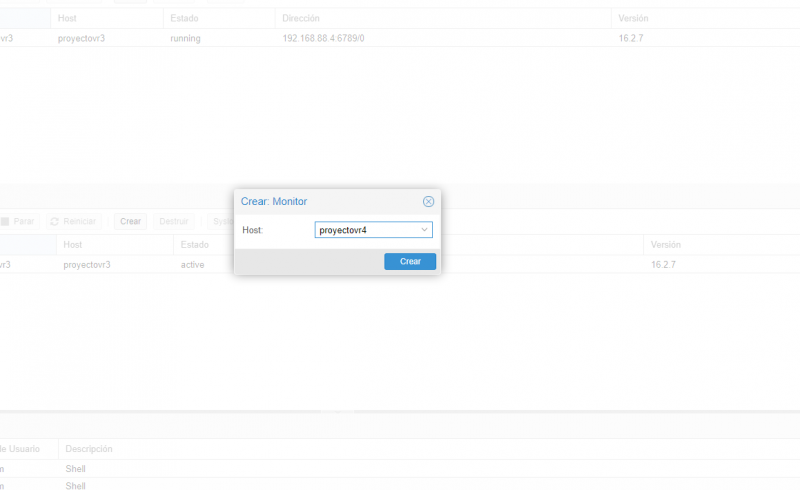

Nos dirigimos a el segundo Cluster y vamos al apartado de Monitor, una vez ahí, hacemos click en Crear

Veremos como se añaden los diferentes nodos

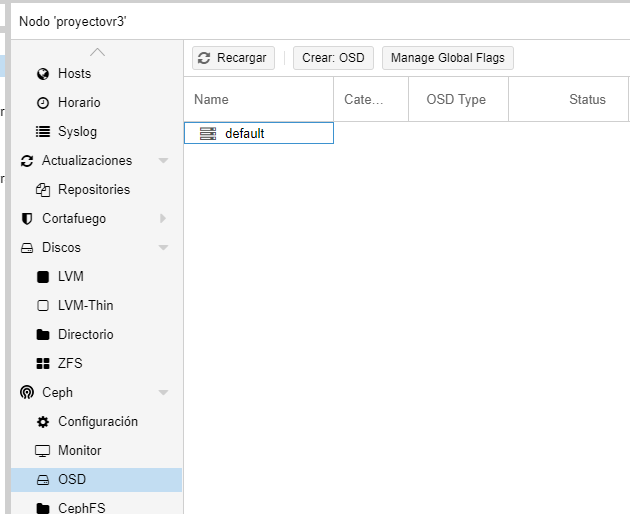

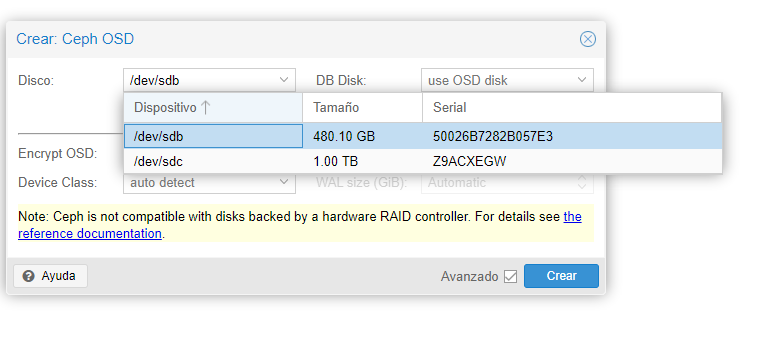

Nos dirigimos a el apartado de Ceph --> OSD --> Crear OSD

Una vez ahí, elegimos el disco que queremos utilizar y hacemos click en crear, en nuestro caso hay que utilizar el disco de 500G

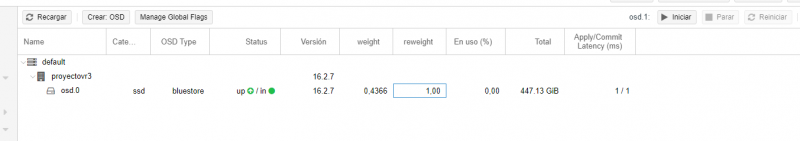

Repetimos el mismo proceso por cada host/disco y finalmente podremos ver como se han añadido todos los discos de los diferentes hosts

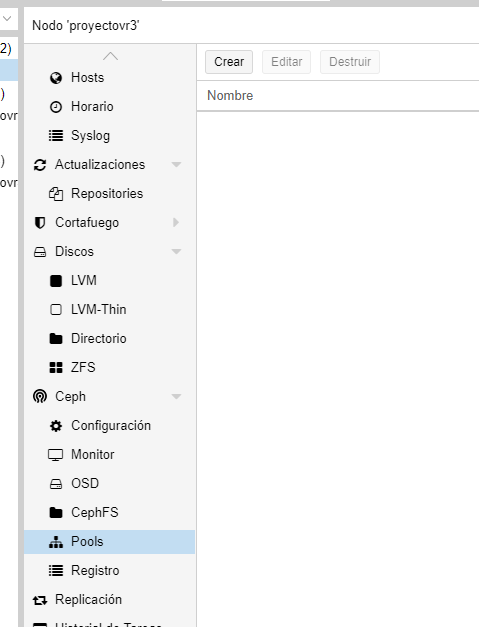

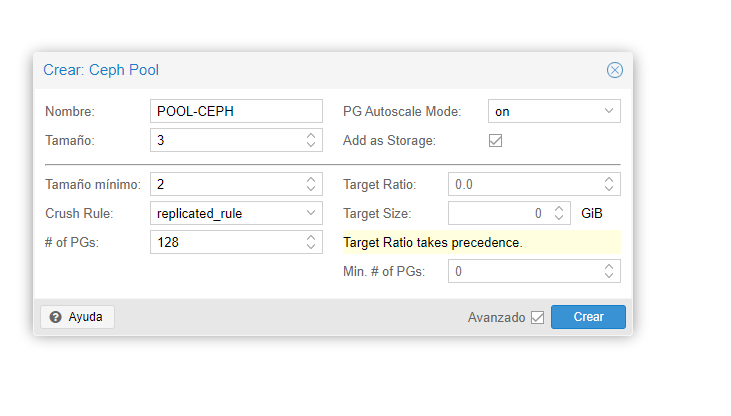

Nos dirigimos al el apartado Ceph --> Pools --> Crear, indicamos la información correspondiente y hacemos click en cerrar

Elegimos el nombre de la Pool, el tamaño etc... y hacemos click en Crear, uan vez creada, la podremos ver en el apartado Pools

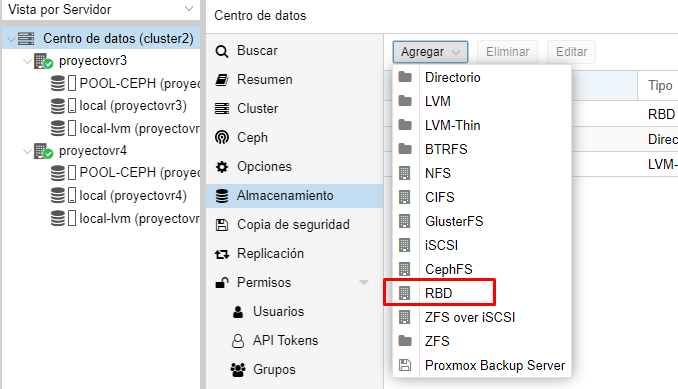

Ahora nos dirigimos a Centro de datos –-> Almacenamiento --> Agregar --> RBD

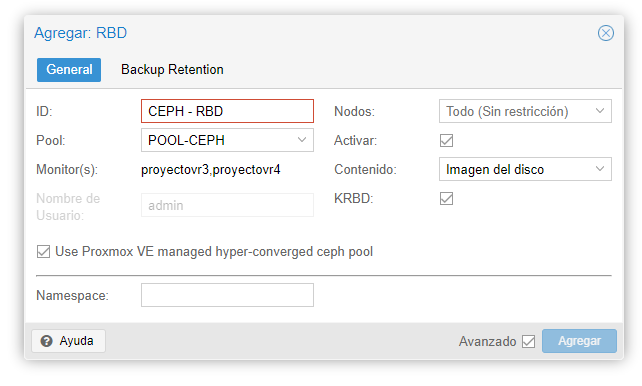

Aquí tenemos que elegir el contenido que va a almacenar, básicamente hay que darle un nombre, y elegir la pool

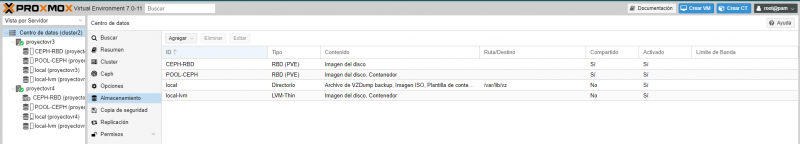

Ahora podemos ver el almacenamiento en los hosts

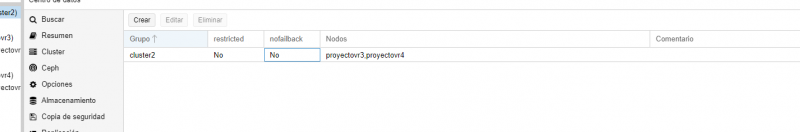

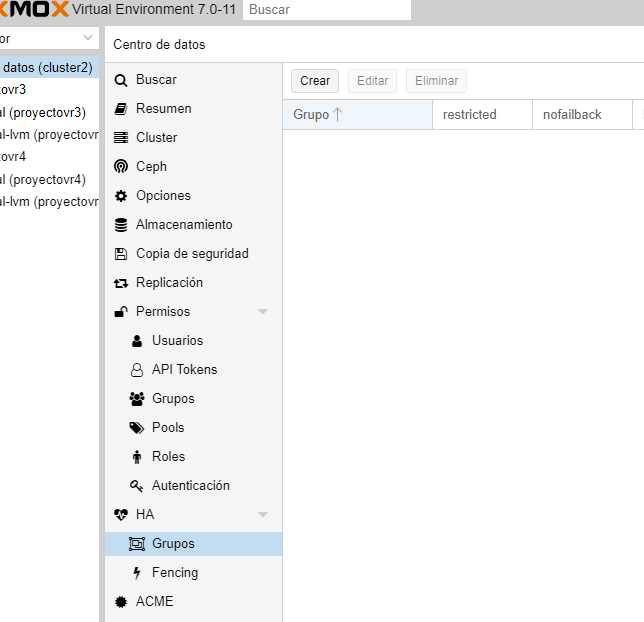

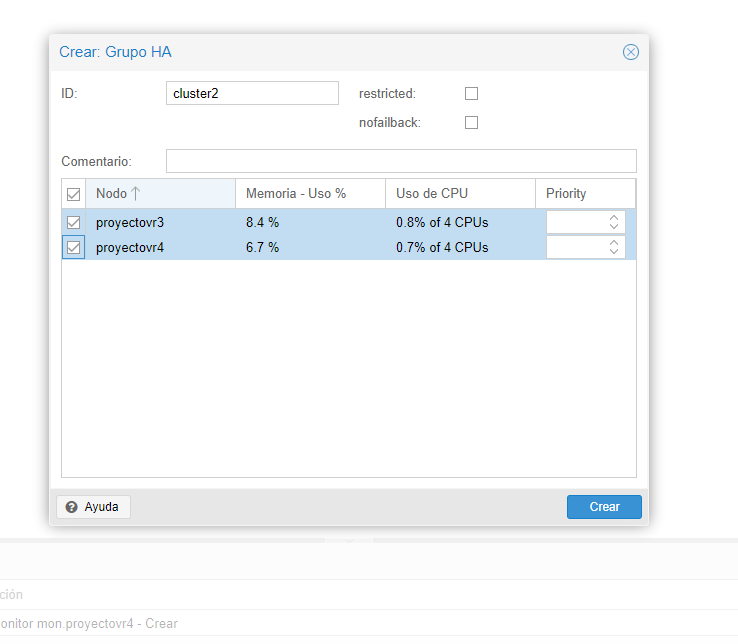

Vamos a crear los Grupos para realizar la Alta disponibilidad

Para ello nos dirigimos a Cluster --> HA --> Grupos --> Crear

Ahora, tenemos que elegir quien queremos que forme parte del grupo y hacemos click en Crear

Ahora solo queda añadir una ISO y crear una maquina para realizar un test y comprobar el correcto funcionamiento, pero antes de eso, hay que hacer una pequeña modificación en el archivo de configuración del Ceph

Abrimos un terminal y nos dirigimos a /etc/ceph/ceph.conf y en la parte de osd_pool_default_min_size ponemos como valor 1, esta va a hacer que el numero mínimo de pools necesarias sean 1 y en osd_pool_default_size, ponemos como valor 2, esto indica el numero de pools que tenemos, en nuestro caso 2

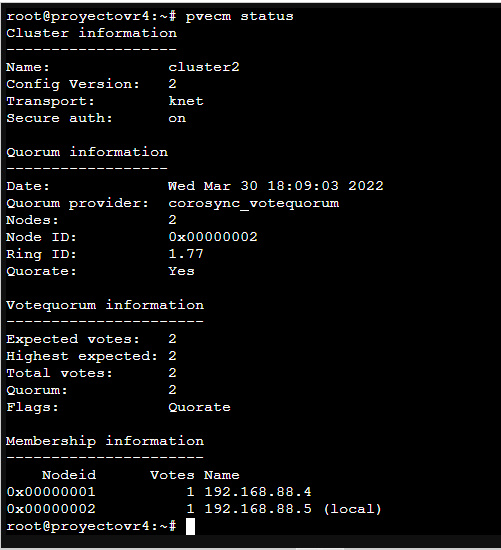

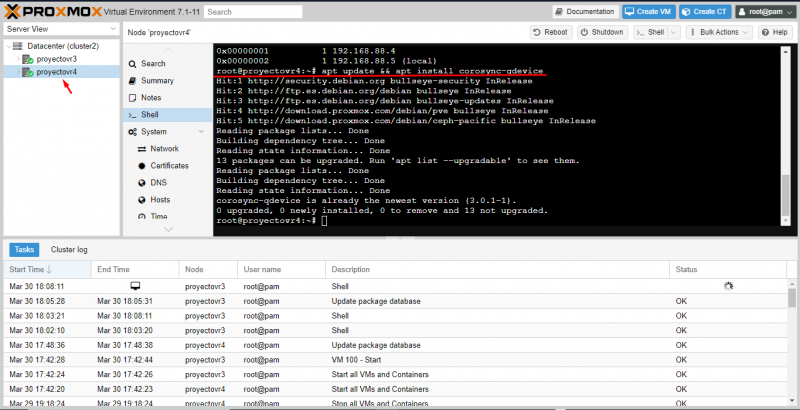

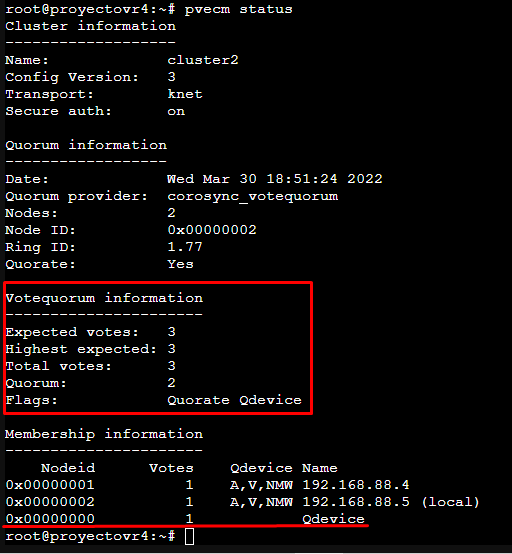

Primero comprobamos el estado actual del cluster con el comando pvecm status, vemos que aparecen los dos nodos que tenemos.

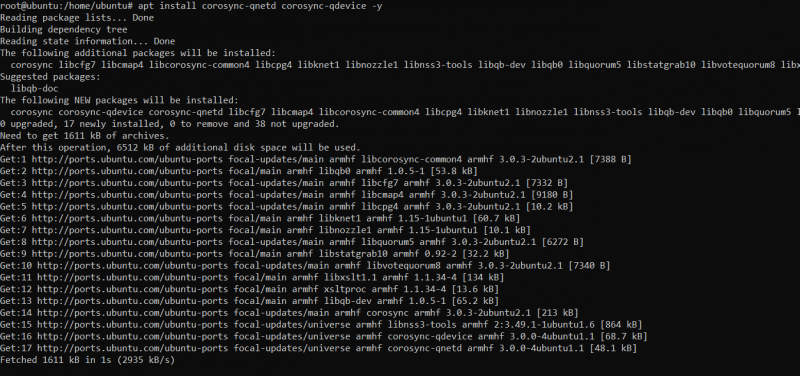

Después instalamos las dependencias corosync-qdevice en ambos nodos del cluster.

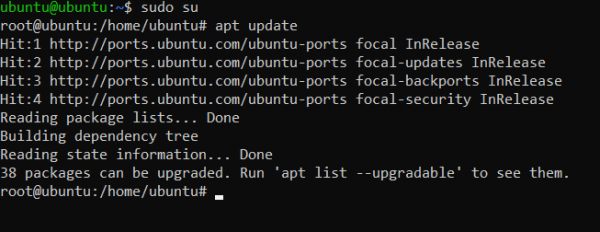

En la raspberry, con permisos root instalamos las dependencias corosync-qdevice y corosync-qnetd.

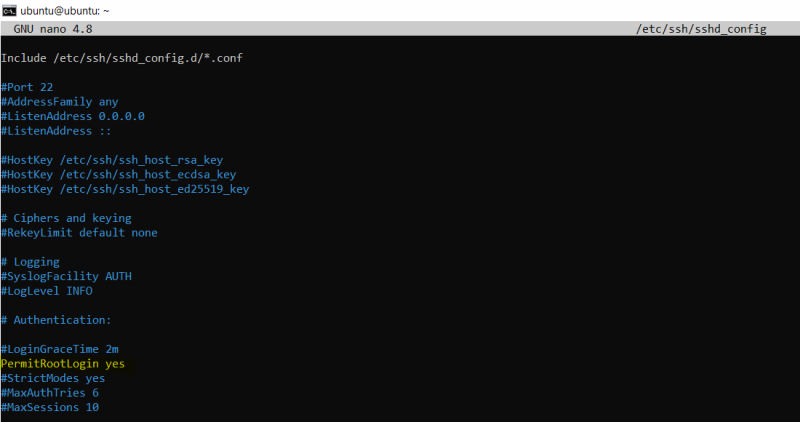

En la raspberry, es necesario tener el servicio ssh activo, y permitiendo el root login en el fichero /etc/ssh/sshd_config

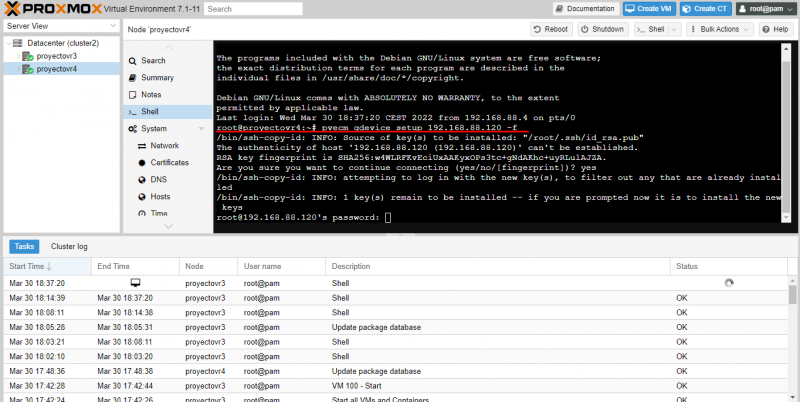

En el nodo master, ejecutamos el comando pvecm qdevice setup 192.168.88.120 -f con la IP de la raspberry e introducimos la contraseña de root

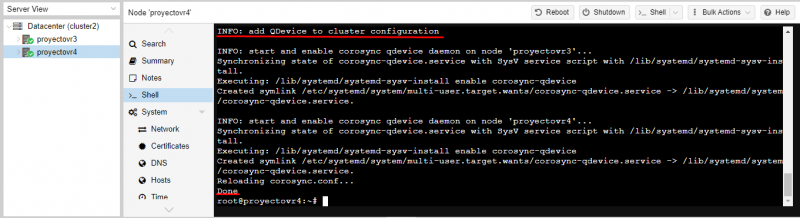

Una vez hecho esto ya está añadido el nodo qdevice, comprobamos con pvecm status que se ha añadido.

Añadimos la máquina virtual a la alta disponibilidad al grupo HA creado anteriormente.

Para testear que está funcionado apagamos el nodo donde está corriendo la MV, y automáticamente se migra al otro nodo.

1. Cluster en funcionamiento normal, los dos nodos encendidos

2. Se apaga el segundo nodo, pendiente de proceso de migración.

3. Se migra automáticamente la máquina al otro nodo y arranca