Grup 4 - 6. Storage pool. Configuració de volum compartit d’alta disponibilitat amb Redhat Ceph RBD, GlusterFS, o altres.

Ceph RBD

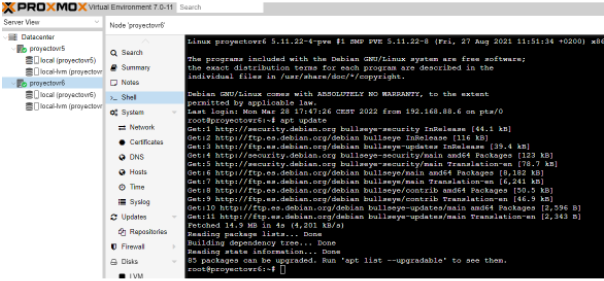

Primero realicamos un "apt update", para actualizar los paquetes antes de crear el "Ceph".

Ahora accedemos al nodo principal y vamos al apartado de "Ceph", ahí nos saldrá el botón de "instalar ceph".

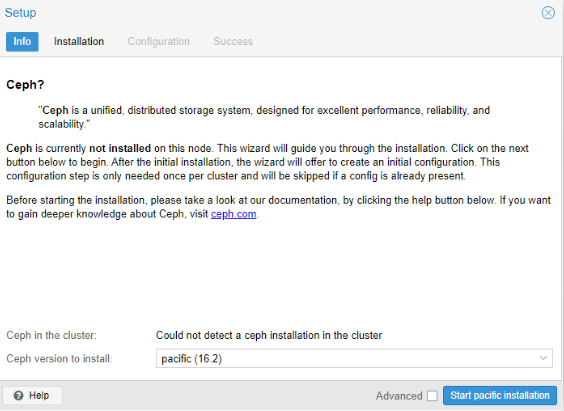

Nos saldrá esta pestaña, aquí no tocamos nada y le damos a "Start pacific installation".

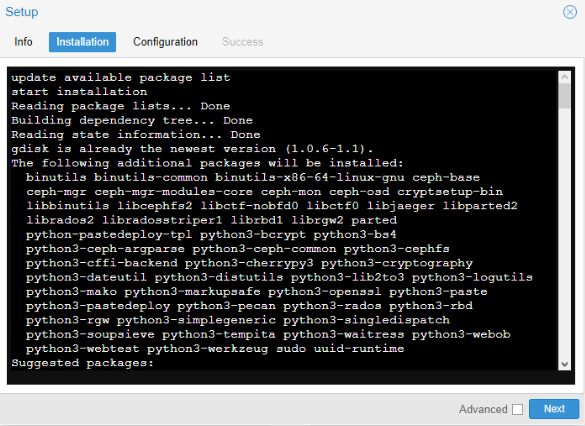

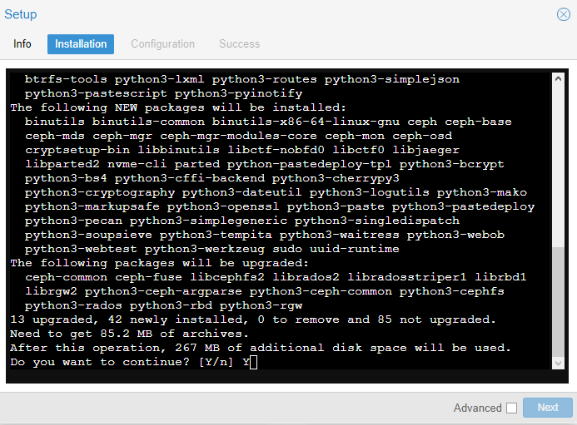

Ahora comenzara la instalación del Ceph en este primer nodo.

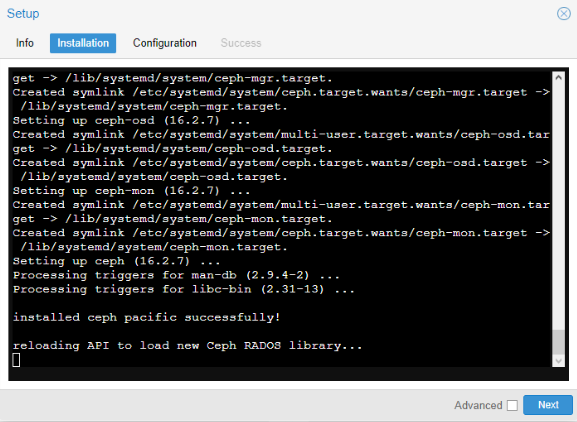

Cuando nos salga "Installed ceph pacific successfully!", le damos a "next".

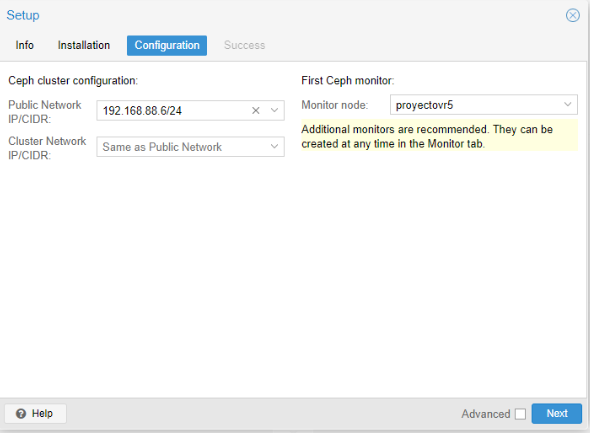

En la configuración, primero ponemos la "Public Network" del nodo que estamos creando el Ceph, y en "Monitor node", ponemos también el mismo nodo.

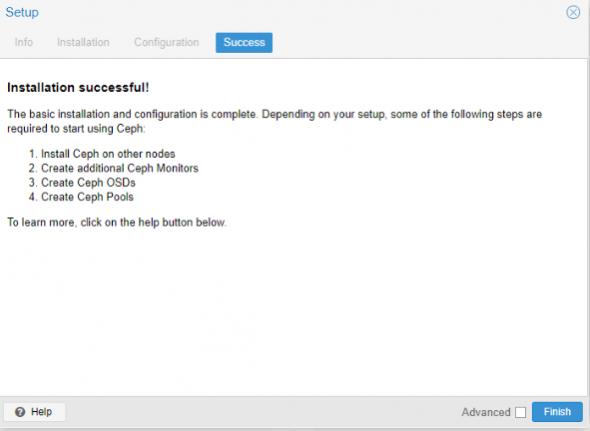

Nos saldrá "Installation Successful", una vez aquí ya le damos a "Finish", para acabar la instalación del Ceph en el propio nodo.

Realizamos los mismo en el otro nodo, simplemente no nos pedirá configurarlo una vez se haya instalado.

Creación de la Pool y del RBD

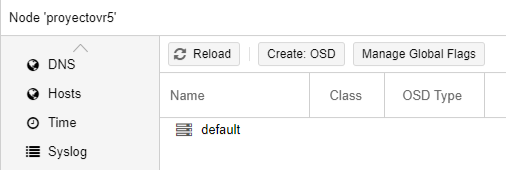

Primero añadimos los discos que vamos que se utilizaran para los de alta disponibilidad, accedemos al "Ceph" del primer nodo y vamos a "OSD".

Seleccionamos la opción "Create: OSD".

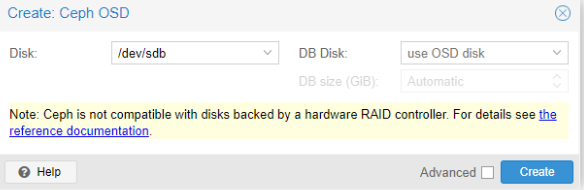

En "Disk", elegimos el disco que se va a utilizar para el HA y el Ceph, y le damos a "Create".

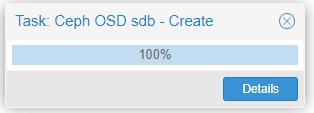

Esperamos a que llegue al 100% y se cierre solo.

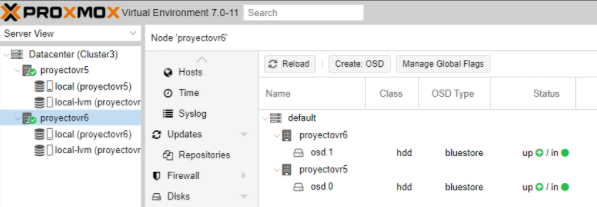

Ahora volvemos a hacer lo mismo en el otro nodo, para que nos quede como en la imagen.

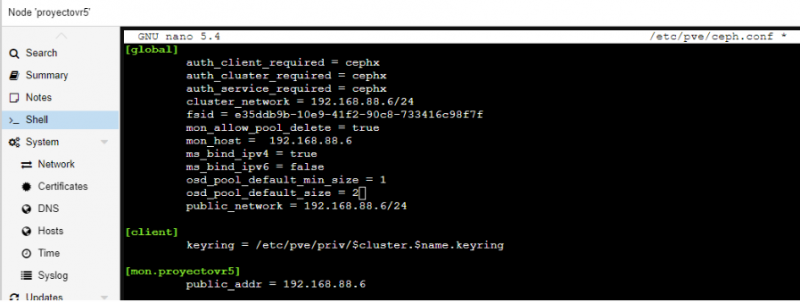

Vamos a configurar el ceph a mano para que nos salga que todo esta "Ok", con solo dos nodos y para ello realizamos este comando.

nano /etc/pve/ceph.conf

Y editamos los campos "osd_pool_default_min_size" y "osd_pool_default_size", tal y como se muestra en la imagen.

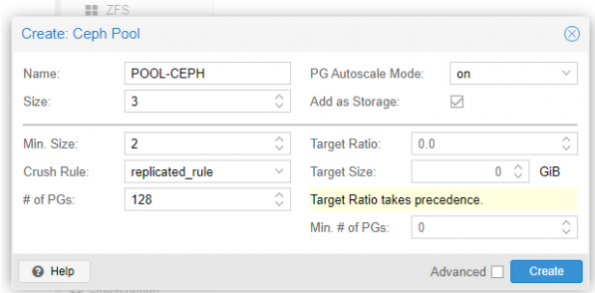

Vamos a en un nodo a "Ceph" y después clicamos en "Pool", ahí creamos una pool, como podemos ver en la siguiente imagen.

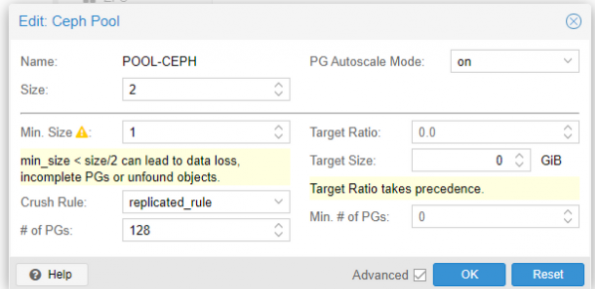

Ahora clicamos en la pool creada y le damos a editar, para aplicar correctamente el numero de nodos, ya que en la creación no te deja poner menos de 2, hay que editar "size" y "Min. Size".

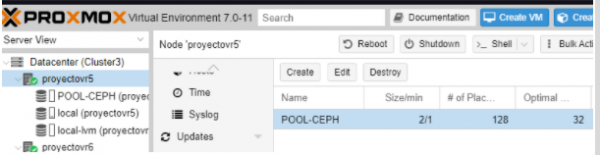

Aquí podemos ver el resultado de la creación de la Pool.

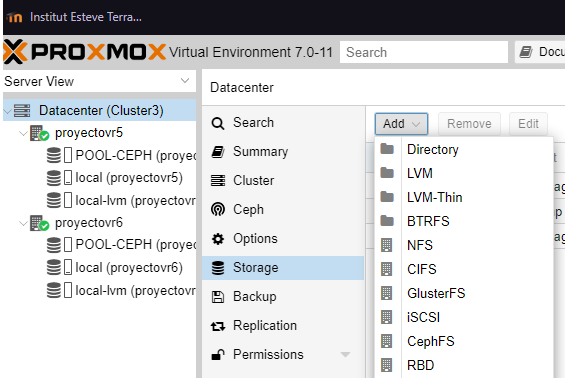

Nos toca crear la pool RBD especifica, para ello en el cluster nos vamos a "Storage", por ultimo en "Add", clicamos en "RBD".

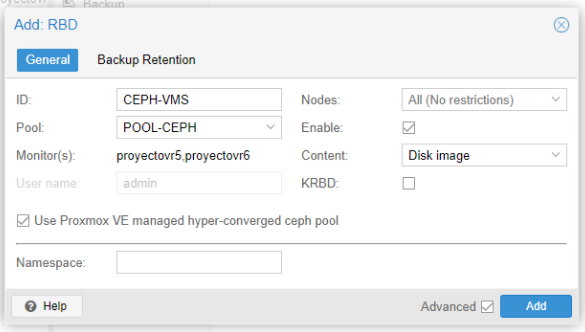

Le ponemos un nombre en ID, y seleccionamos la pool creada anterior mente en el Ceph.

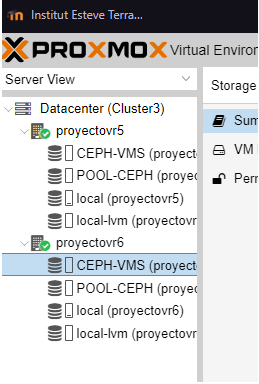

Podemos ver que se ha creado la pool correctamente en los dos nodos.

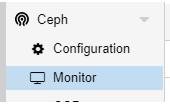

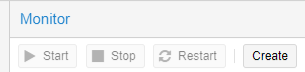

Ahora volvemos al apartado del Ceph y nos vamos a "Monitor", para añadir el segundo nodo como monitor

Ahora en "Monitor", le damos a "Add", para añadir al segundo nodo.

Seleccionamos el segundo nodo y le damos a "Create".

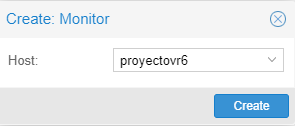

Ya tendríamos el segundo nodo añadido.

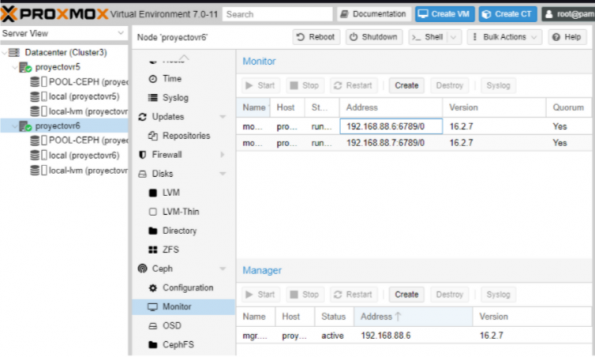

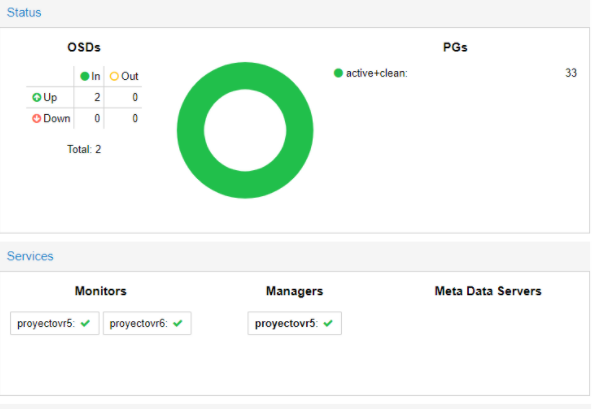

Por último comprobamos como podemos ver en las 2 siguientes imágenes que esta funcionando correctamente, con todo en verde.

HA Proxmox

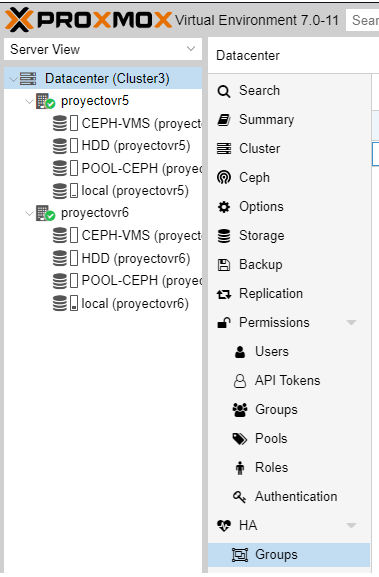

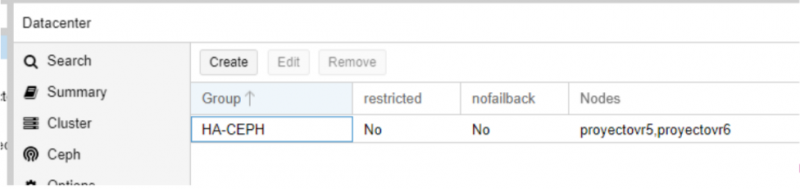

Clicamos en el cluster y buscamos "HA", después nos vamos a "Groups", para crear un grupo para la alta disponibilidad.

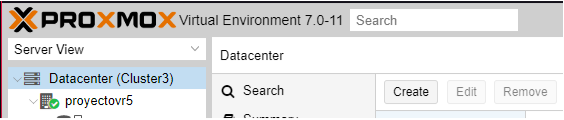

Dentro de "Groups", le damos a "Create", para crearlo.

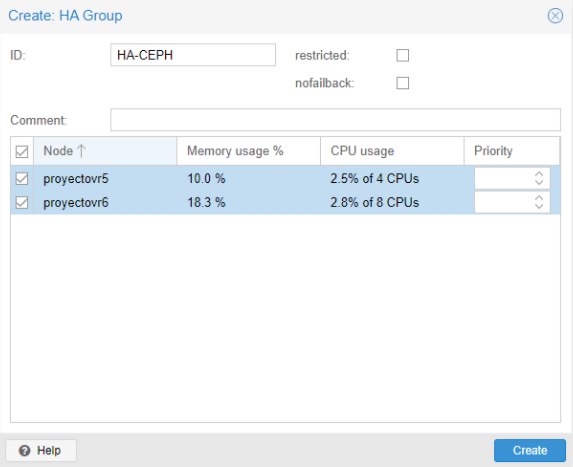

Ahora, le ponemos un nombre en "ID" y seleccionamos los 2 nodos que tenemos y le damos a "Create".

Comprobamos que se haya creado correctamente.

Ahora nos vamos a "HA".

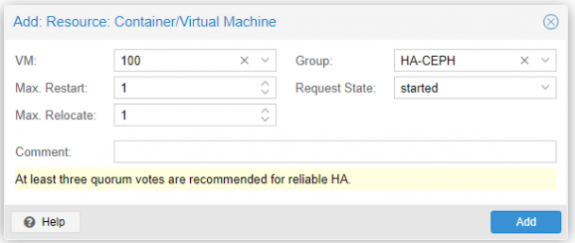

Le damos a "Add", ahí se nos abrirá esta pestaña donde seleccionamos el numero de la VM y seleccionamos el grupo creado previamente en "Group".

Y nos aseguramos de que se haya añadido correctamente.

Raspberry Pi Qdevice

Utilizamos este método, para conseguir la HA, ya que con solo 2 nodos el Ceph no funciona y las maquinas no se pasan entre nodos si uno esta caido.

Nos descargamos la herramienta "Raspberry Pi Imager", lo instalamos y lo ejecutamos, ahí seleccionamos la versión de Ubuntu server prefiramos y marcamos donde se instalara el SO.

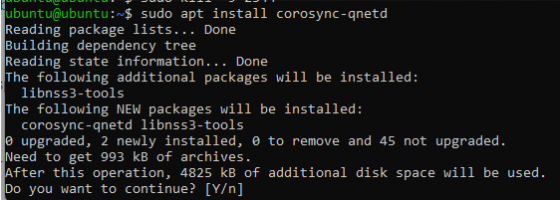

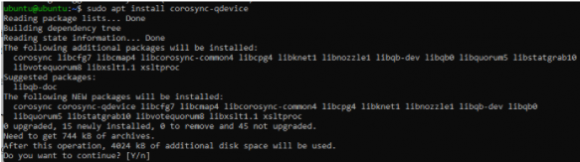

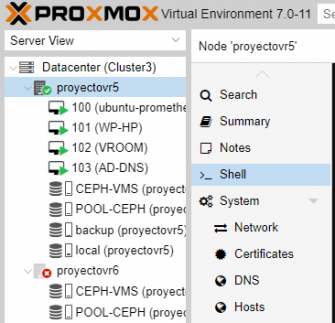

Ahora, por SSH accedemos a la Raspberry, en el cual tenemos que instalar los 2 comandos que se ven en la siguientes 2 imágenes, para poder conectar con Proxmox.

sudo apt install corosync-qnetd

sudo apt install corosync-qdevice

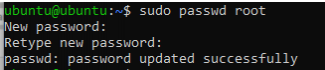

Ahora necesitamos habilitar el usuario "root", para poder conectar con Proxmox.

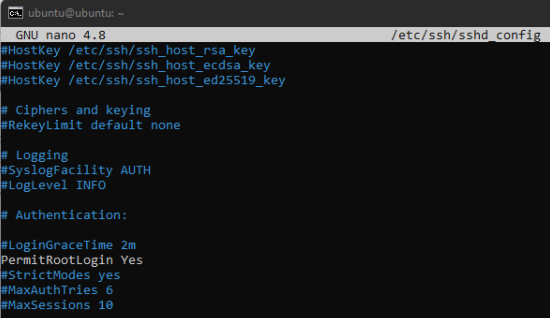

Ahora nos vamos a la configuración del SSH y habilitamos la opción de permitir el acceso root, ya que la conexión, con Qdevice se realiza por SSH.

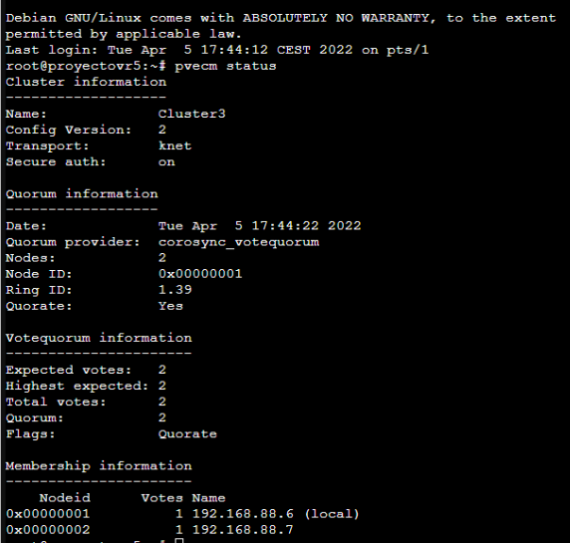

Comprobamos con el comando, que no este la Raspberry conectada.

pvcecm status

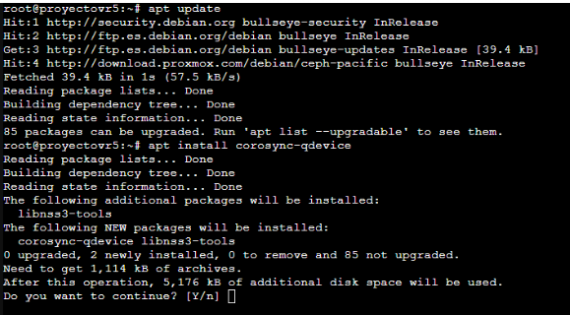

Actualizamos los paquetes en el nodo e instalamos

sudo apt install corosync-qdevice

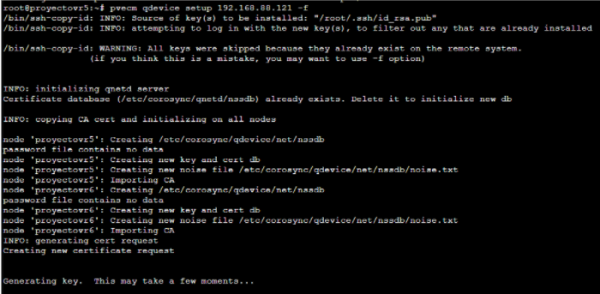

Por ultimo conectamos la Raspberry con esta linea:

pvecm qdevice setup <ip> -f

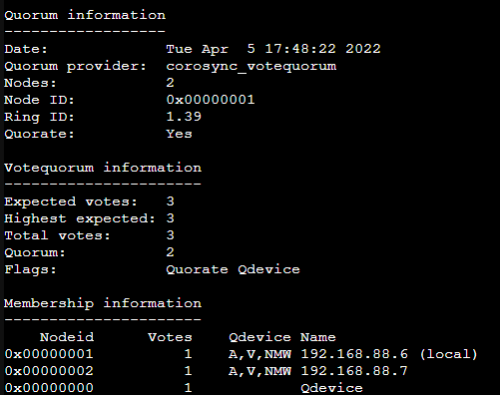

Y podemos ver que se ha añadido correctamente la Raspberry

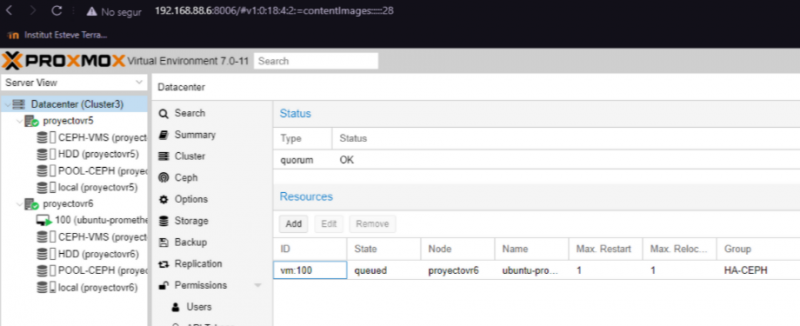

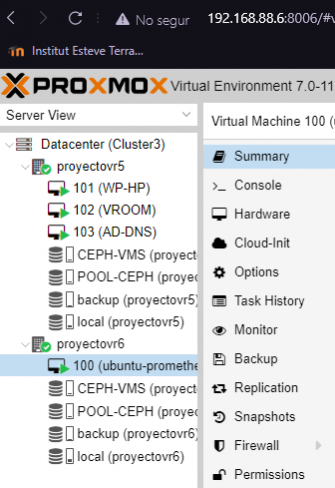

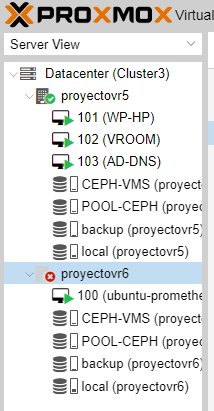

Vamos a apagar el nodo 2 donde está el prometheus, para comprobar que la máquina pasa de nodo.

Podemos ver que hemos apagado el nodo y que la VM estaba en el nodo apagado.

Podemos ver que la máquina se ha pasado.