IETI Cloud - G1

Volver a Projecte IETI Cloud - Grup 1.

2. Diseño DMZ. Análisis, Diseño y Documentación

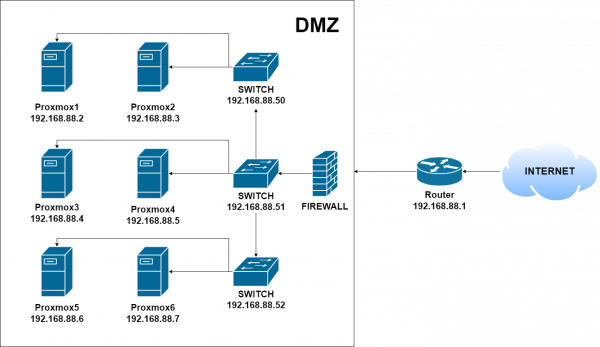

En el diseño de la red podemos encontrar una DMZ, un red interna y una red externa(internet).Como podemos ver en el diseño de la red, la red interna esta preparada para la comunicación entre clústers y la DMZ compuesta de 6 maquinas(nodos) que estarán dentro de los clústers.

3. Montaje Hardware CPD

Montaje del hardware para alojar IETI Cloud

Componentes

- Router: 1

- Armaris Rack (MicroConnect): 2

- Switches: 3

- Sevidores (proporcionados por el centro): 6

- SO Proxmox: 128GB SSD

- Almacenamiento interno: 1TB HDD

- Pool compartido: 480 GB

- Tarjeta de red: 1

Montaje nodo

En cada nodo hemos montado y instalado sus 3 discos correspondientes, a parte de una tarjeta de red adicional para cada clúster.

Montaje rack

Montamos los nodos en el rack y a continuación procedemos a instalar Proxmox.

Previamente montamos un switch por cada 2 nodos para mantener separados los clusters.

4. Instalación del software de virtualización (Proxmox) y clusterización.

- Descargamos la imagen ISO de la pagina oficial del Proxmox.

https://www.proxmox.com/en/downloads

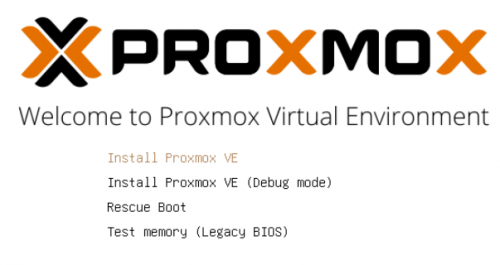

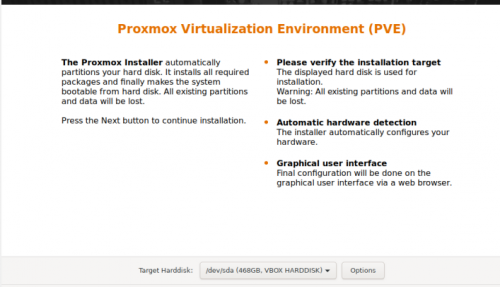

- Elegimos el disco donde se instalara Proxmox.

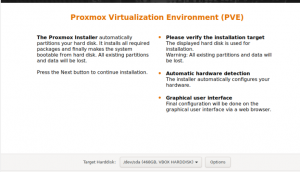

- Comenzamos la instalación seleccionando la opción Proxmox VE.

- Seleccionamos el disco donde instalaremos Proxmox, en este caso elegimos el SSD de 128GB.

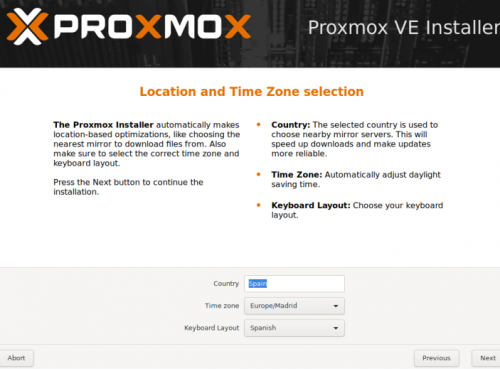

- Definimos el país, la zona horaria y el layout del teclado.

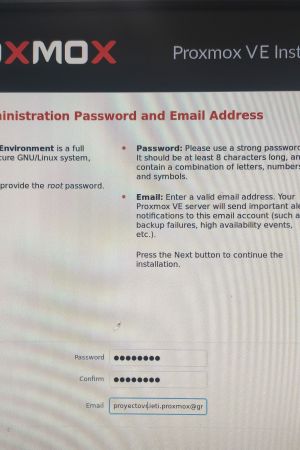

- Indicamos la contraseña de acceso del usuario root y un correo donde enviara información adicional y alertas.

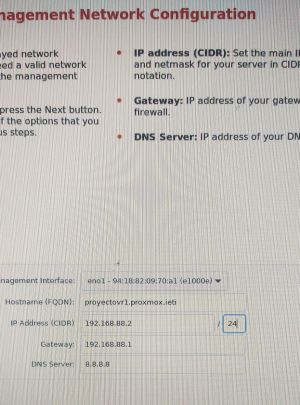

- Introducimos los siguientes datos referentes a la red.

- Tarjeta de red de acceso: eno1

- Hostname: proyectovr(numero de nodo).proxmox.ieti

- IP Address: 192.168.88.X/24 (rango de ip de 2 - 7)

- Gateway: 192.168.88.1

- DNS Server: 8.8.8.8

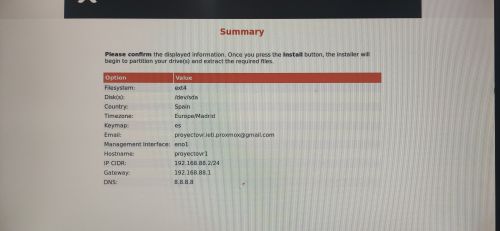

- Resumen de la configuración que hemos establecido y procedemos a la instalación de Proxmox.

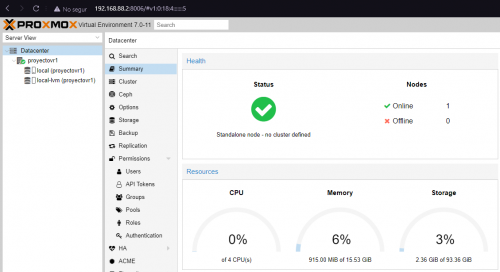

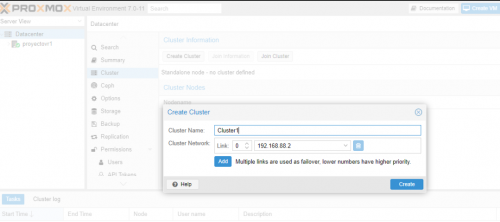

- Prueba de acceso a Proxmox con usuario root.

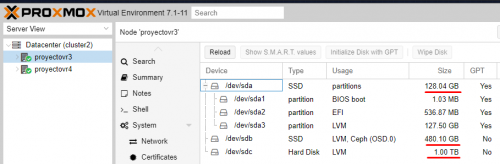

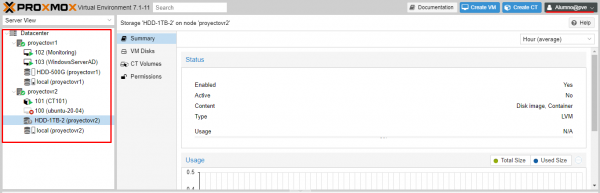

- Ejemplo de las especificaciones de un nodo.

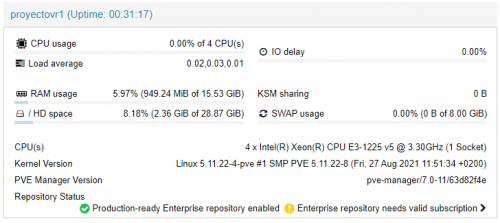

- Desde nuestro Datacenter elegimos la opción Clúster.

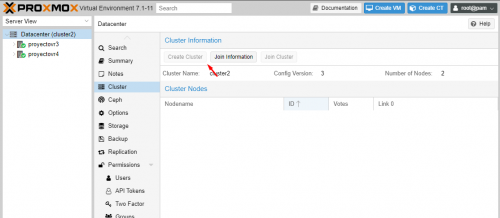

- Procedemos a la creación de nuestro clúster y elegimos la red donde se creara, a continuación copiaremos el texto que utilizaremos para unir los nodos.

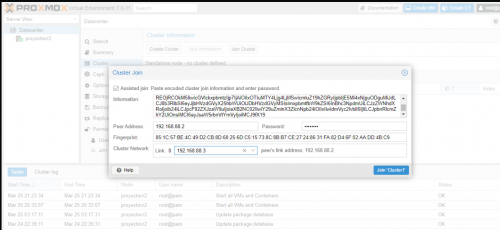

- Pegamos el texto anterior y elegimos la red donde hemos creado nuestro clúster, también especificaremos la red desde donde vamos a unirnos.

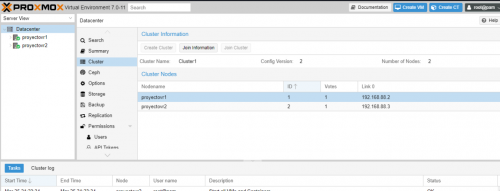

- Finalmente podemos observar que el nodo ha sido creado con éxito.

5. Políticas de almacenamiento

- Disponemos de 3 discos:

- SO Proxmox: 128GB SSD

- Almacenamiento interno: 1TB HDD

- Pool compartido: 480GB SSD

6. Creación del Storage Pool

Configuración del Ceph

- Des del nodo accedemos al menú del Ceph y procedemos a instalarlo.

- Seleccionamos el numero de versión, en este caso hemos elegido la 16.2.

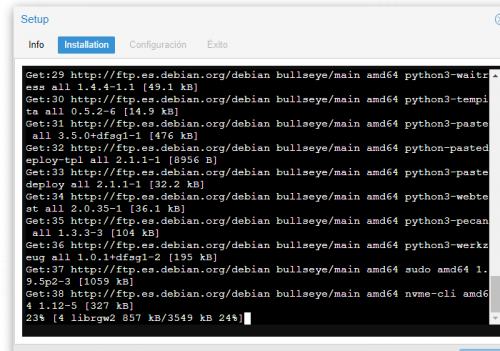

- Esperamos a que finalice el proceso de instalación.

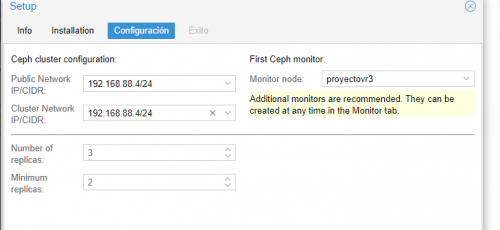

- Introducimos las redes donde actuara el Ceph.

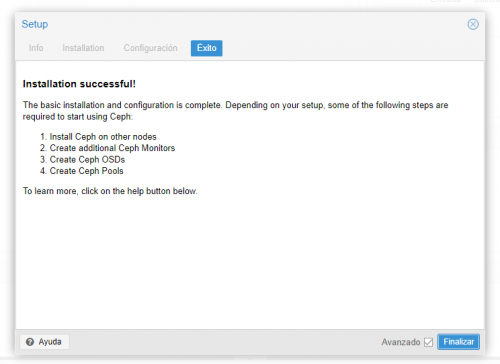

- Una vez tenemos el Ceph creado nos faltaría replicar el proceso en nuestro otro nodo.

Asignación del Disco

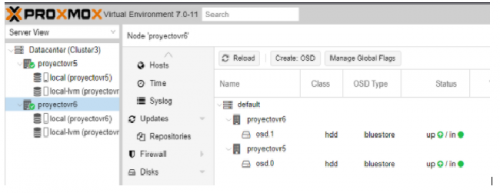

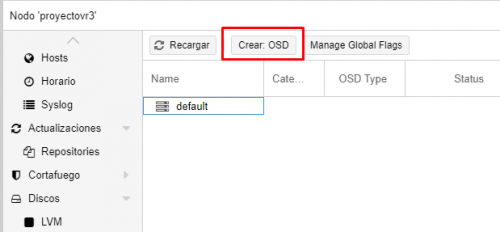

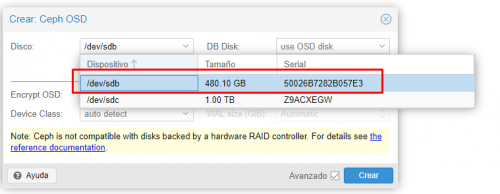

- Para crear el OSD (Object Storage Daemon) accedemos al nodo y seleccionamos la opción Crear OSD

- Seleccionamos el disco que utilizaremos, en nuestro caso elegiremos el de 480GB SSD.

- Este es el resultado una vez añadido.

Creación del Pool

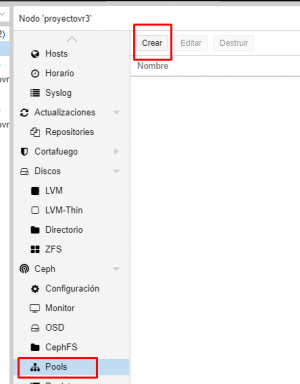

- Vamos al apartado de Pool y seleccionamos la opción de crear.

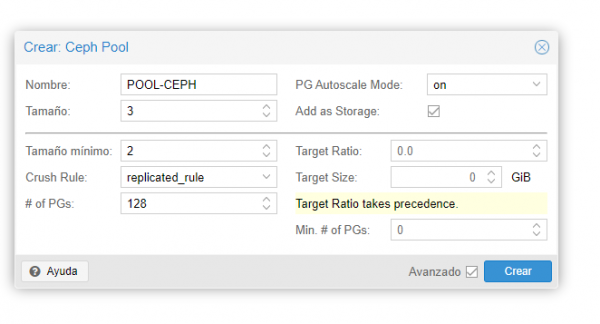

- Introducimos el nombre del pool y lo creamos.

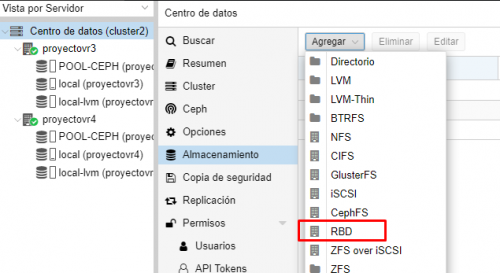

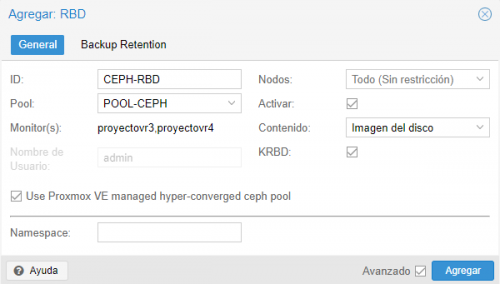

- Para crear el RBD vamos al menú del Datacenter del Clúster, en el apartado de almacenamiento encontramos la opción Añadir donde seleccionaremos RBD.

- Introducimos la ID y el pool.

- Resultados del pool creado anteriormente.

5. HA (Alta disponibilidad)

Creación de la HA

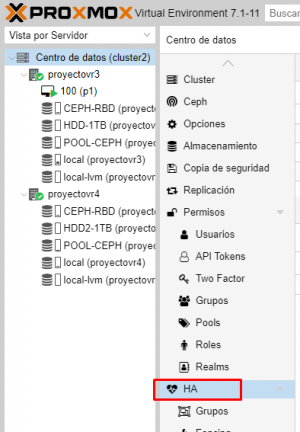

- Para crear el HA accedemos al menu de Alta Disponibilidad dentro del Datacenter.

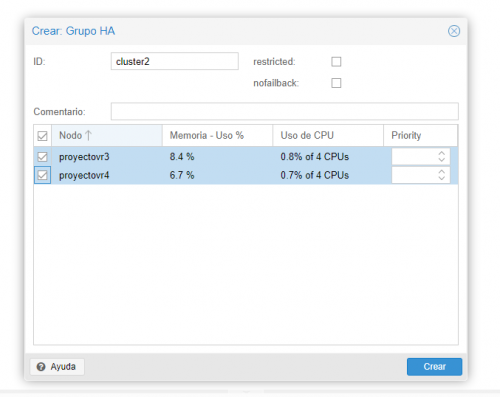

- Introducimos el nombre y los nodos que formaran parte del grupo de HA.

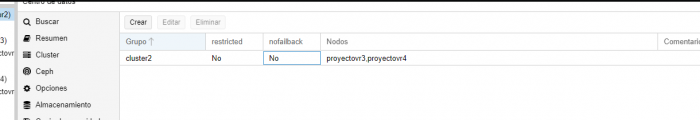

- Este es el resultado de la creación del Clúster con HA.

Raspberry como tercer nodo

Como únicamente disponemos de dos nodos para el Clúster, la HA no esta disponible, esto se debe a que necesitamos un mínimo de tres, por esta razón configuraremos una Raspberry como tercer nodo.

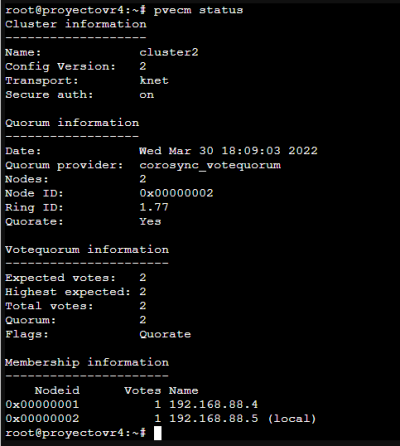

- Mostramos que únicamente tenemos dos nodos configurados dentro de Proxmox.

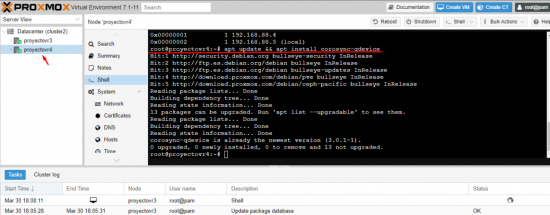

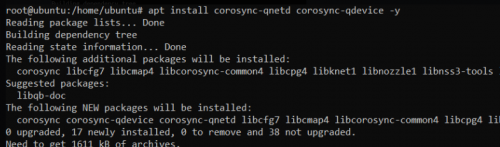

- Instalamos las dependencias en los dos nodos.

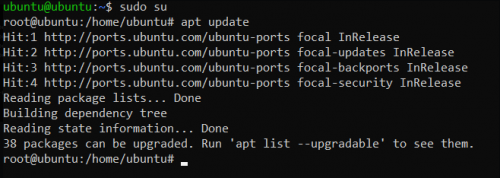

- A través de SSH nos conectamos a la Raspberry y actualizamos los paquetes.

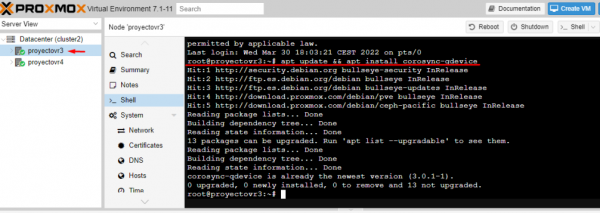

- Instalamos los paquetes necesarios en la Raspberry.

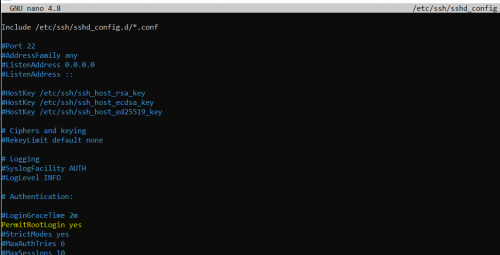

- Habilitamos el acceso via SSH al usuario root para poder ejecutar el siguiente paso.

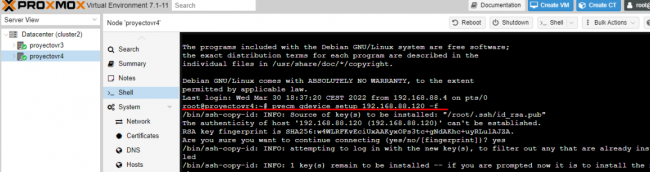

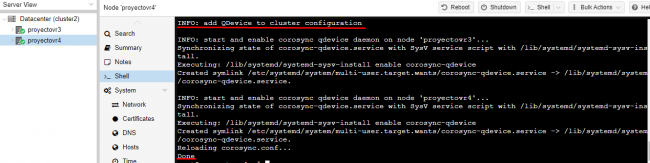

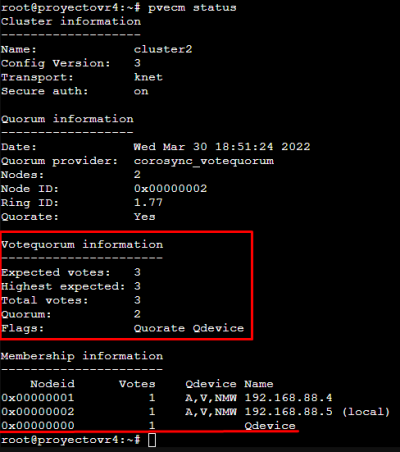

- Añadimos el nodo creado, definiéndolo como tipo qdevice en el Clúster.

- Finalmente, podemos ver que actualmente tenemos 3 nodos en el clúster gracias a la comanda anteriormente ejecutada.

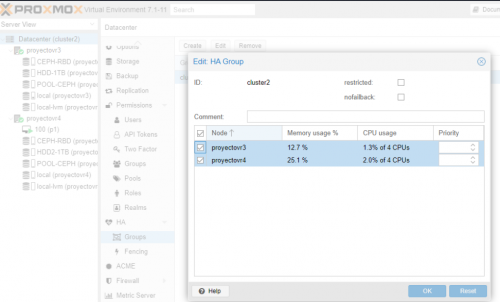

- Creamos el grupo de HA i seleccionamos los nodos que formaran parte del mismo.

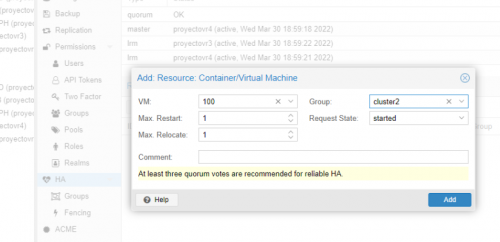

- Añadimos la MV creada anteriormente y la asignamos al grupo de HA creada.

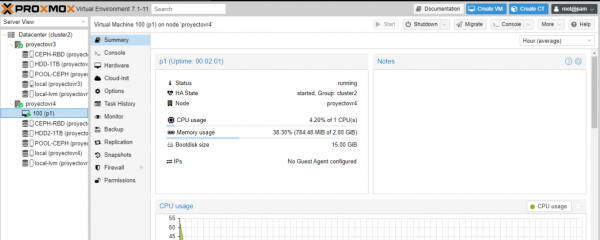

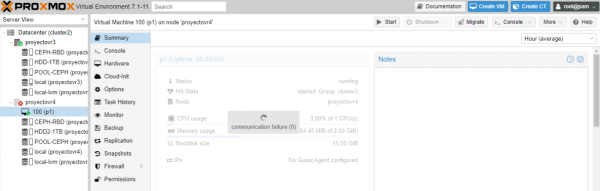

- Comprobamos que la MV esta encendida en el nodo ProyectoVR4

- Para poder comprobar la alta disponibilidad apagamos el nodo y esperamos hasta que la MV migre.

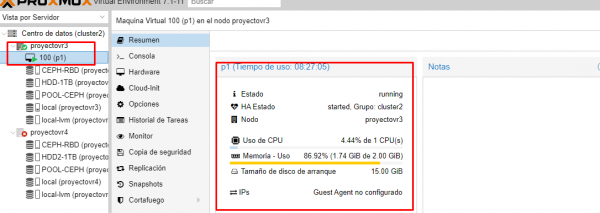

- Comprobamos que después de apagar el nodo, la MV se ha migrado i sigue funcionando correctamente en el nodo ProyectoVR3.

8. Política de Usuarios Proxmox: privilegios, cuota, sistema de autenticación.

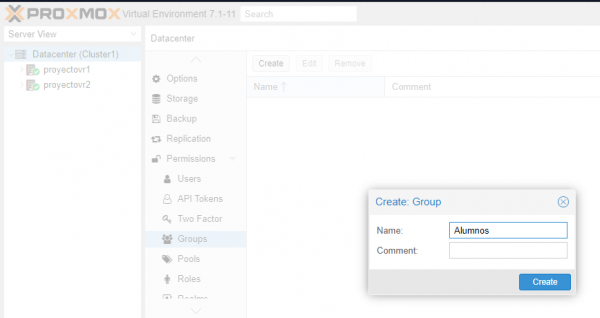

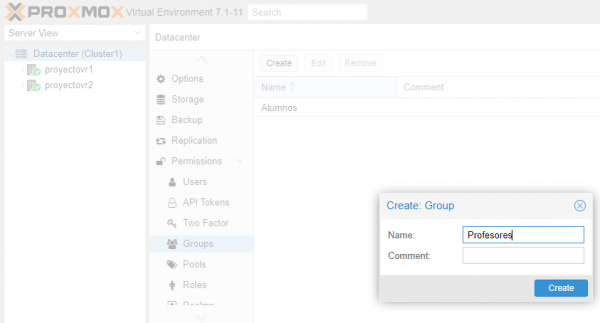

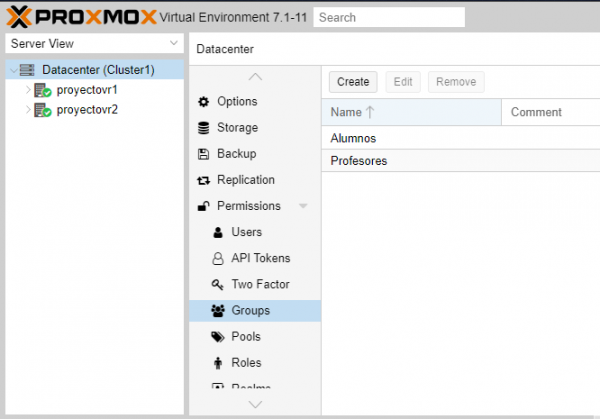

Creación de Grupos

- Creamos un grupo llamado Alumnos el cual contendrá todos los usuarios creados para el alumnado.

- Creamos un grupo llamado Profesores el cual contendrá todos los usuarios que crearemos para el profesorado.

- Comprobamos que los grupos se han creado correctamente.

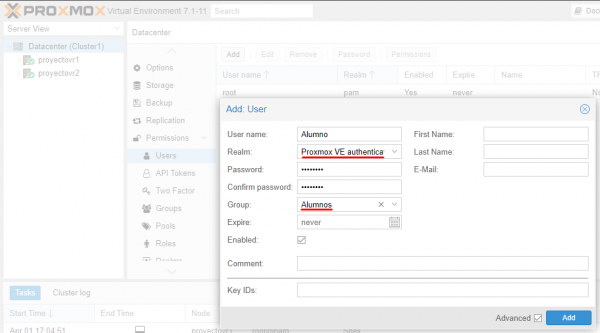

Creación de Usuarios

- Para la creación de los usuarios nos dirigimos a Centro de Datos → Permisos → Usuarios.

- Añadimos un usuario llamado Alumno y le assignamos el grupo Alumnos que hemos creado anteriormente. También definiremos el método de autenticación del usuario, en este caso utilizaremos el servidor interno que nos proporciona Proxmox VE.

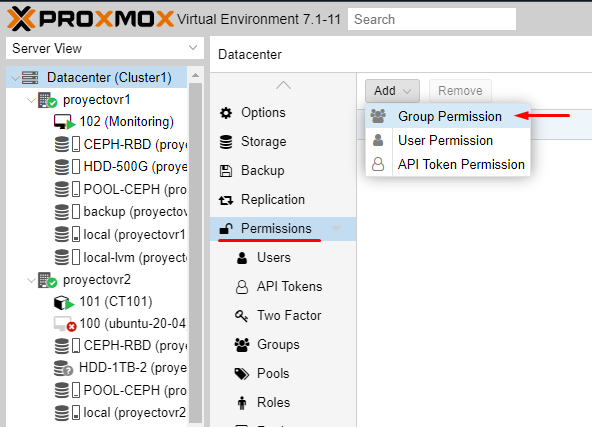

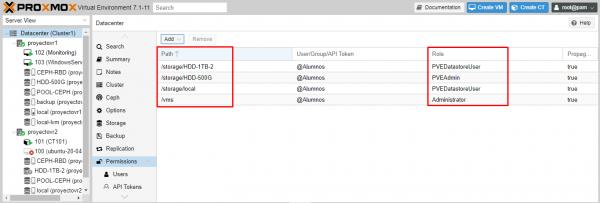

- Para definir los permisos de cada grupo accederemos a Centro de Datos -> Permisos -> Permisos de Grupo.

- Ahora crearemos los permisos del grupo Alumnos definiendo que solo pueda generar maquinas virtuales y visualizar los discos donde se guardaran.

- Comprobamos, accediendo con el usuario Alumno, que los permisos están definidos correctamente y que únicamente podemos ver los discos y que, por ejemplo, no tendremos acceso a la Shell de los nodos.

7. Monitorización de Proxmox

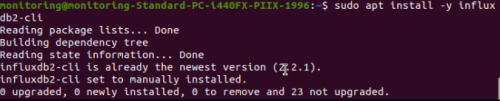

Instalación de InfluxDB

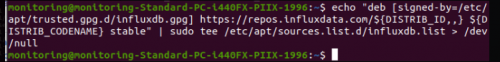

- Agreguemos la clave InfluxDB a nuestro sistema:

- Realizamos la instalación de los repositorios.

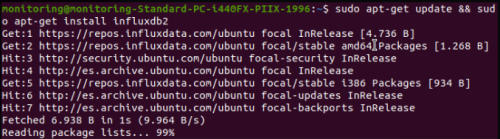

- Actualizamos la máquina e instalamos InfluxDB.

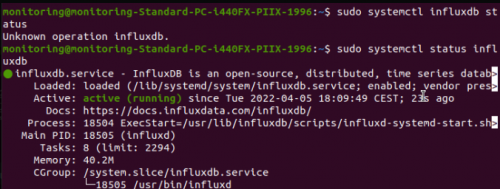

- Arrancamos el servicio y miramos como esta.

- Agregamos al arranque del sistema.

- Instalamos el modo gráfico de InfluxDB para que así tenga un aspecto visual mucho más cómodo para todos.

- Abrimos nuestro navegador, establecemos el puerto y ya tendremos acceso a InfluxDB.

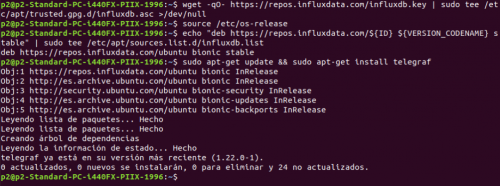

Instalación de Telegraf

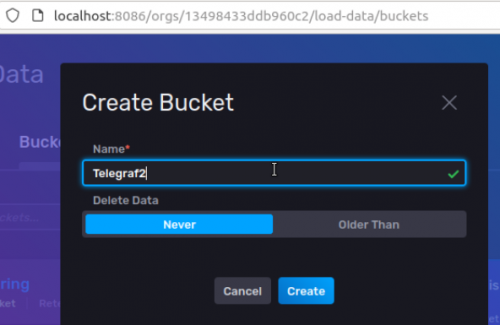

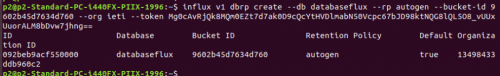

- En InfluxDB crearemos un contenedor, para ello ingresamos a InfluxDB -> Datos -> Pool -> Create new bucket

- Agregamos el GPG de Telegraf y realizamos la instalación del mismo.

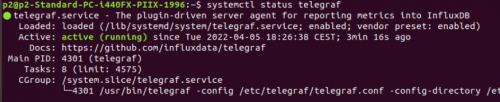

- Revisamos que el servicio este UP.

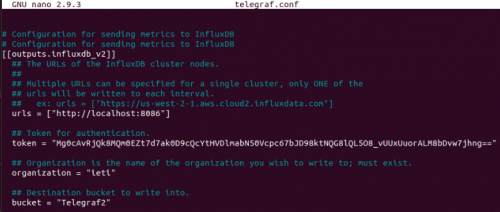

- Accedemos al fichero de configuración de Telegraf.

- Modificamos el fichero de la siguiente manera.

- - En el apartado url: la url del servidor InfluxDB.

- - Token: añadir el token del administrador de Influxdb.

- - Bucket: añadir el contenedor creado anteriormente.

- - Organization: Añadir el nombre de la organización.

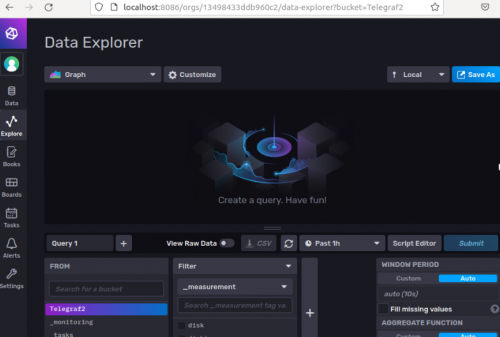

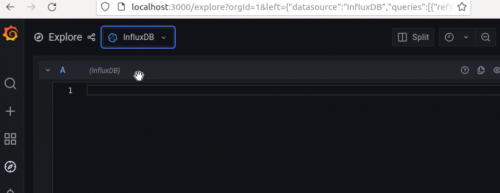

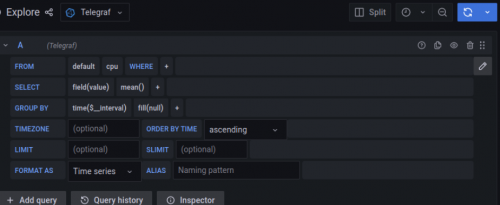

- Reiniciamos el servicio y accedemos de nuevo a la pagina, nos dirigtamos el apartado de Explorer y nos tiene que aparecer esto mismo.

Instalación de Grafana

- Realizamos la instalación de todos los paquetes necesarios para el funcionamiento de Grafana.

- Agregamos la versión estable de Grafana.

- Actualizamos de nuevo la máquina.

- Instalamos el paquete de Grafana.

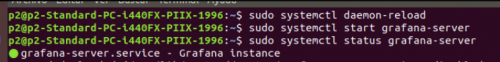

- Efectuamos toda esta secuencia de comandos para así revisar que el Grafana esté instalado de manera correcta.

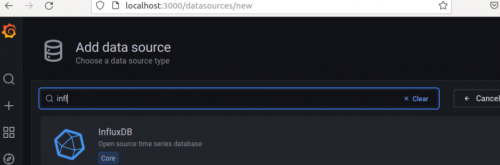

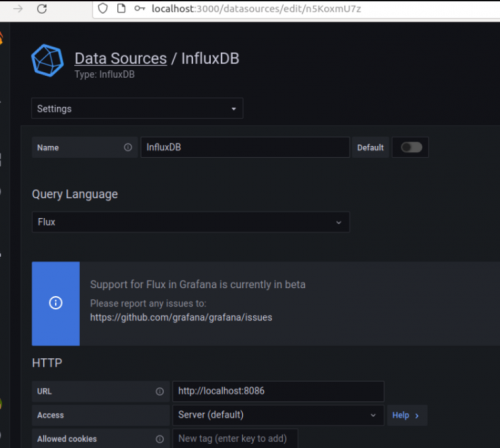

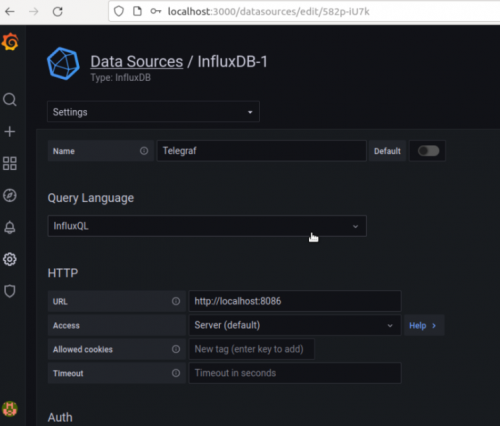

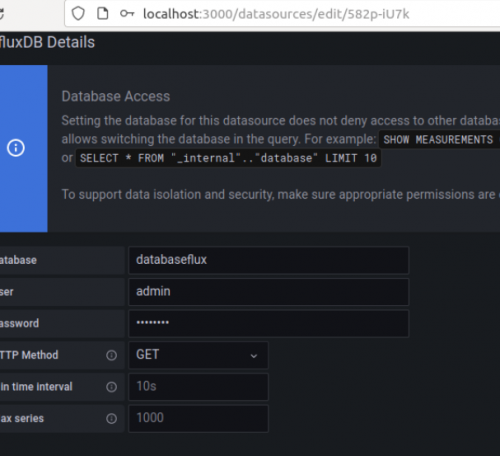

- Para la configuración de Grafana accedemos a nuestro navegador por el puerto 3000 y accedemos a Configuration → Data sources -→ Add data source y añadimos InfluxDB.

- Editamos para así poderlo añadir.

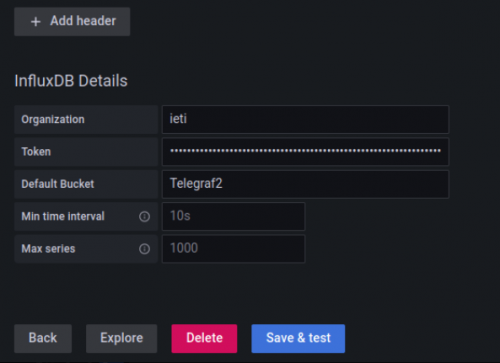

- Añadimos la información necesaria.

- Si está bien configurado veremos este resultado si accedemos a Data Source.

- Para que pueda funcionar de manera correcta tenemos que crear la base de datos, que seria con el siguiente comando.

- Creamos un nuevo Data Source en Grafana.

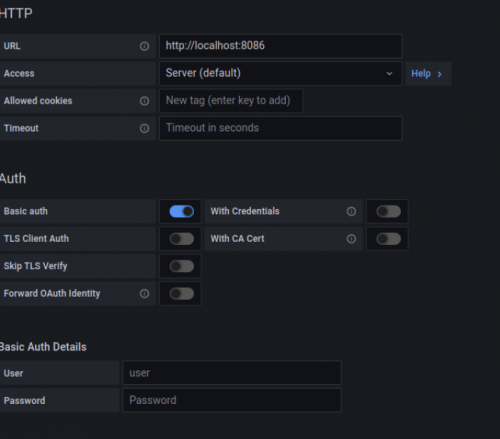

- Activamos la opción de Basic Auth

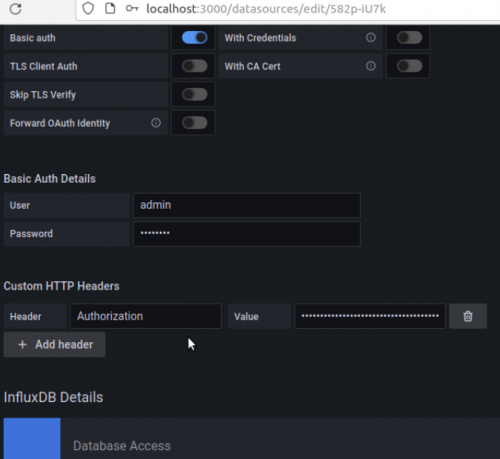

- Ponemos los datos del usuario y contraseña de InfluxDB.

- Finalmente, añadimos la información que falta.

- Si todos los pasos los hemos seguido de manera correcta, accediendo a Explore tenemos que ver esto.

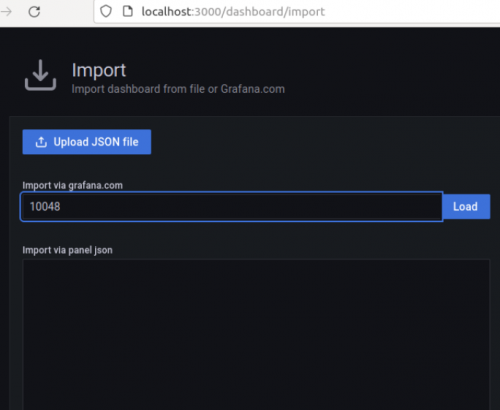

- Para poder tener un Dashboard vamos a importar una plantilla ya generada, en este caso la 10048. Para ello accedemos a Create → Import

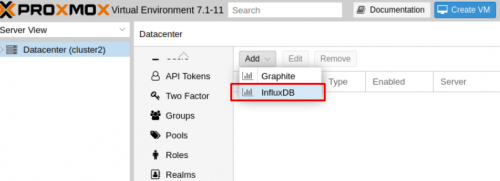

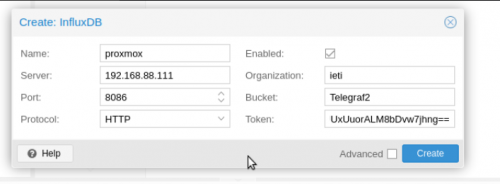

- A continuación accedemos a Data Center de nuestro cluster de Proxmox y le damos a Metric Server -> Add -> InfluxDB

- Completamos con los datos del InfluxDB.

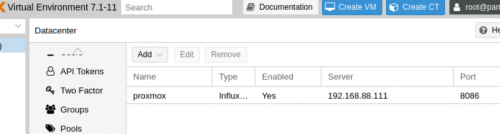

- Este sería el resultado con el Metric Server agregado.

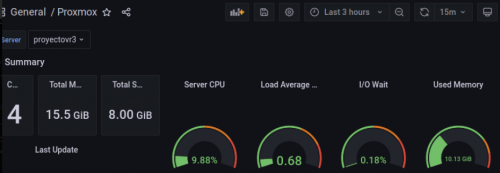

- Y este el resultado de la monitorización siendo visualizada desde Grafana.

Alertas

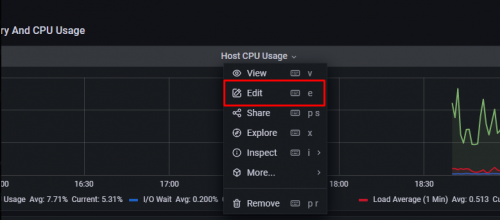

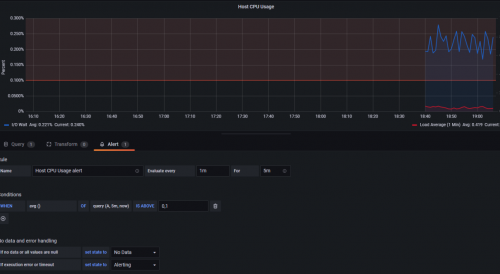

- Para crear la alerta nos vamos al Dashboard que hemos cargado anteriormente y buscamos sobre que queremos generar la alerta, en este caso será sobre GPU, le damos a EDIT.

- Editamos la variable de la plantilla, en este caso lo tenemos que dejar con el nombre del nodo.

- Nos vamos al apartado Alert y ya podemos editar la alerta, le asignamos por ejemplo que al 10% de uso se genere alerta, ya que sería una prueba.

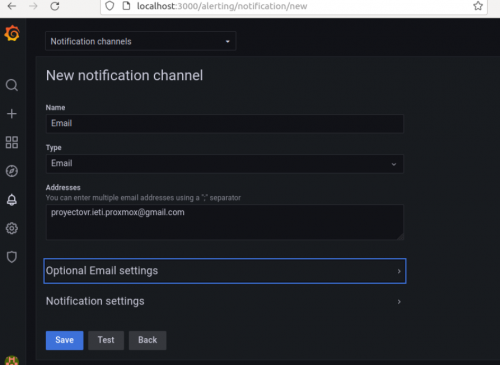

- Nos dirigimos a Alerting para así poder asignar el método de alerta.

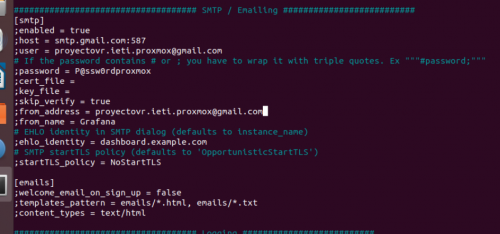

- Editamos el archivo de configuración.

- Configuramos el apartado de SMTP.

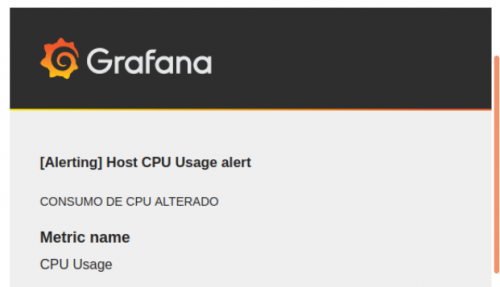

- Esta sería la alerta que nos llega el correo electrónico.